任何企业要想在竞争中保持领先地位才能生存,这始终是一场斗争。 电子商务的出现导致了市场的全球化以及在线市场研究和竞争对手监控工具的引入。 在这种情况下,网站抓取发挥了重要作用。

在本文中,您将学习如何使用网络抓取通过节省资金、监控价格、跟踪产品性能、按时获得供应以及通过使用网络抓取使您的列表保持最新,从而在竞争中保持领先地位。

除了为公司提供一种收集数据的方式外,它还是一种监控竞争对手活动、自动化工作流程并将机器学习引入流程的方式。 毫无疑问,网站抓取有可能将品牌转变为在线零售数据驱动世界的主要参与者。

如果您有兴趣发现如何通过电子商务网络抓取将 Office Depot 产品导出到 excel 或 JSON 文件,我们有一些建议。 我们的电子商务 网页抓取软件 可以抓取 Office Depot 产品。

什么是 Office Depot?

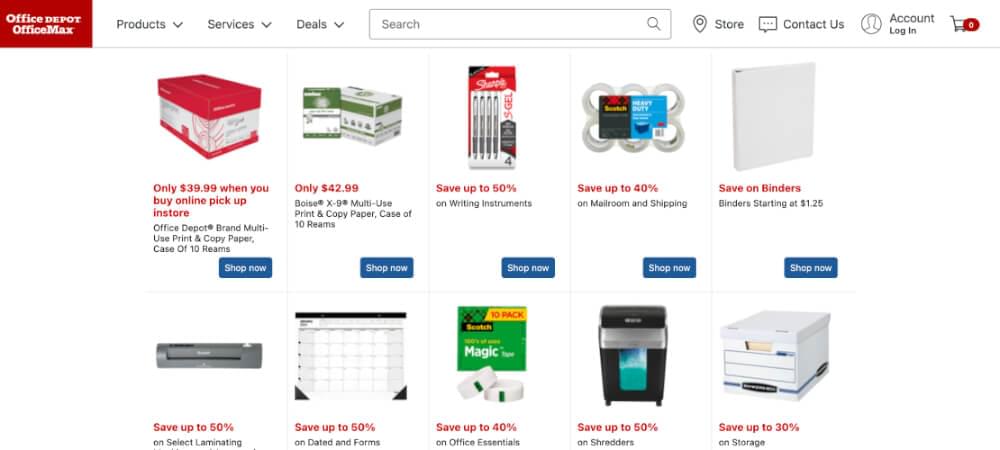

Office Depot Corporation 还拥有 OfficeMax 和 Grand & Toy 品牌,是美国最大的办公用品零售商之一,也是美国人最大的雇主之一。 目前,该公司拥有 1,400 多家门店和 38,000 多名员工,每年通过其运营产生超过 11 亿美元的收入。 该公司的网站提供种类繁多的产品,从办公椅到书桌、文具用品、学习用品等等,而且价格合理。 让我们先看看 Office Depot 提供的一些办公用品;

办公用品

无论您是在家、工作还是在学校,您都需要一些基本的办公用品。 在您的办公桌和用品柜中放置合适的办公产品非常重要,这将使您的工作日或上学日高效进行,并帮助您迅速高效地完成项目。 从收藏品中获取全年所需的所有基本办公用品,让您时刻准备就绪。

- 新办公用品

查看新办公用品系列,包括家具、流行技术以及适用于家庭和办公室的各种创新解决方案。 如果您有兴趣了解最新发布的产品,请经常回来查看。

Discbound Planner 系统、贴纸书和配件旨在为您提供每日需求的详细概览。 将所有这些放在一起并让您的创造力大放异彩,使这些产品成为您日常计划中不可或缺的一部分。

- Office Depot 公司办公用品

美国各地的许多企业都发现,办公家具和商务办公用品对其业务的成功运作至关重要。 我们的业务通常需要在短时间内交付可靠、价格合理且质量上乘的产品,以确保业务继续平稳运行,并确保员工和客户得到妥善照顾。 如果您选择了正确的公司和供应商,这些持续需求可能带来的潜在压力将会增加或减少,具体取决于您选择的公司或供应商。 一旦您找到一家可以帮助您满足所有需求的可靠公司,业务中的许多事情就会变得更容易获得。

每个订单的重要性,无论您是经营小型企业、在家工作,还是为跨国公司寻找公司办公用品,对于您公司的持续稳定和发展都至关重要。 办公环境可以显着影响个人和团队的生产力和效率。 处于良好工作状态和令人愉快的设备将产生与过时、磨损或看起来疲倦的库存完全不同的结果。 如果基本的商务办公用品供应不足或损坏,很容易失去交易和客户。

我们将在这篇博文中讨论抓取 Office Depot,以及如何使用抓取网站的最佳工具之一 Crawlbase 来完成。

使用 Crawlbase 抓取 eOffice Depot

作为顶级网络抓取工具之一,Crawlbase 旨在使开发人员和企业能够从网络上匿名收集小型和大型数据。 对于希望在使用 Crawlbase 提供的服务的同时以较低的费用和不被注意的方式抓取高质量数据的企业主来说,它是最受青睐的网络抓取工具。 他们的服务涵盖许多平台和网站类型,使其成为这些企业的首选网络抓取工具。

Crawlbase 被认为是顶级网络抓取工具是有原因的,尽管用户为此“支付”的费用更少。 这将允许您在准备好您的项目时做出正确的网络抓取器选择,因为有一个免费帐户选项允许您抓取与付费用户相同的数据,尽管有一些限制。

- 使用 Crawlbase 抓取产品价格、产品信息和产品图片

- 拥有来自不同制造商的产品的图像和描述将是非常具有挑战性的。 从制造商网站复制数据和图像非常耗时,但不可行。 永远等待制造商提供详细信息和图像是没有意义的。

- 如果您经营电子商务业务,则需要从 Office Depot 中获取所有产品详细信息、价格、描述和图像。

- 我们的抓取工具会定期收集数据和图像以上传到您的网站。

- 自动监控竞争对手的过程

- 必须持续监控您的策略才能有效。 必须检查产品的可访问性。 密切关注竞争对手为您自己的类似产品提供的产品促销和特别优惠,并监控竞争对手为您销售的类似产品提供的交易,这一点至关重要

- 在不比较竞争对手的价格和产品的情况下将任何业务可视化是不可能的。

- 使用 Office Depot,我们可以自动从竞争对手那里收集价格、颜色、尺寸和供货情况。

- 利用列表数据抓取 Office Depot 产品

- 数据抓取 对于此类特定的产品相关数据,我们的连接功能可能会面临挑战。

- 有时您需要来自特定列表页面的特定产品数据,例如畅销书或关键字搜索结果。 因此,要获得产品的这些详细信息,您必须使用准确的仪器。

- 此工具允许您按类别、最高评价、仅翻新、子类别、通过产品页面 URL、按品牌和通过搜索关键字从有关畅销书的产品页面中抓取无限量的产品数据。

最后的评论

我们生活在一个竞争激烈的网络世界中,网络抓取是在竞争中保持领先地位的最佳方式之一。 此外,如果您想利用近期在线销售的扩张,您将受益匪浅。

如今,电子商务蓬勃发展已不是什么秘密,在 Crawlbase 的帮助下,它也可以为您的业务带来蓬勃发展! 您的企业正在寻找一种方法来增强自动化、机器学习,或者只是以准确的方式监控竞争对手的活动。 没有比 Crawlbase 更好的地方可以在一个屋檐下获得这些服务。

您可以使用以下方式抓取 Office Depot 产品评论和数据 爬虫库. 可以解析所有产品和类别数据,包括卖家名称、标题、URL、商户ID、类别树、图像URL、品牌、颜色、样式、产品概述、可用性、描述、到货时间、尺寸、型号、图像、价格、起始价格、最后价格、功能、评论和评级,以及提取所有产品和类别数据。