抓取网站并不是一件容易的事,尤其是当您开始处理数千或数百万个请求时。 您的服务器将开始受到影响并被阻止。

您可能知道,Crawlbase 可以帮助您避免这种情况,但在本文中,我们不会讨论这一点。 但相反,我们将检查如何轻松抓取和抓取任何网站。

这是一个实践教程,因此如果您想遵循它,请确保您在 Crawlbase 中有一个工作帐户。 它是免费的,所以继续吧 在这里创建一个。

提取 URL

在 Crawlbase 中注册时您会注意到的第一件事是,我们没有任何花哨的界面来添加您想要抓取的 URL。 不,因为我们希望您拥有完全的自由。 因此,我们创建了一个您可以调用的 API。

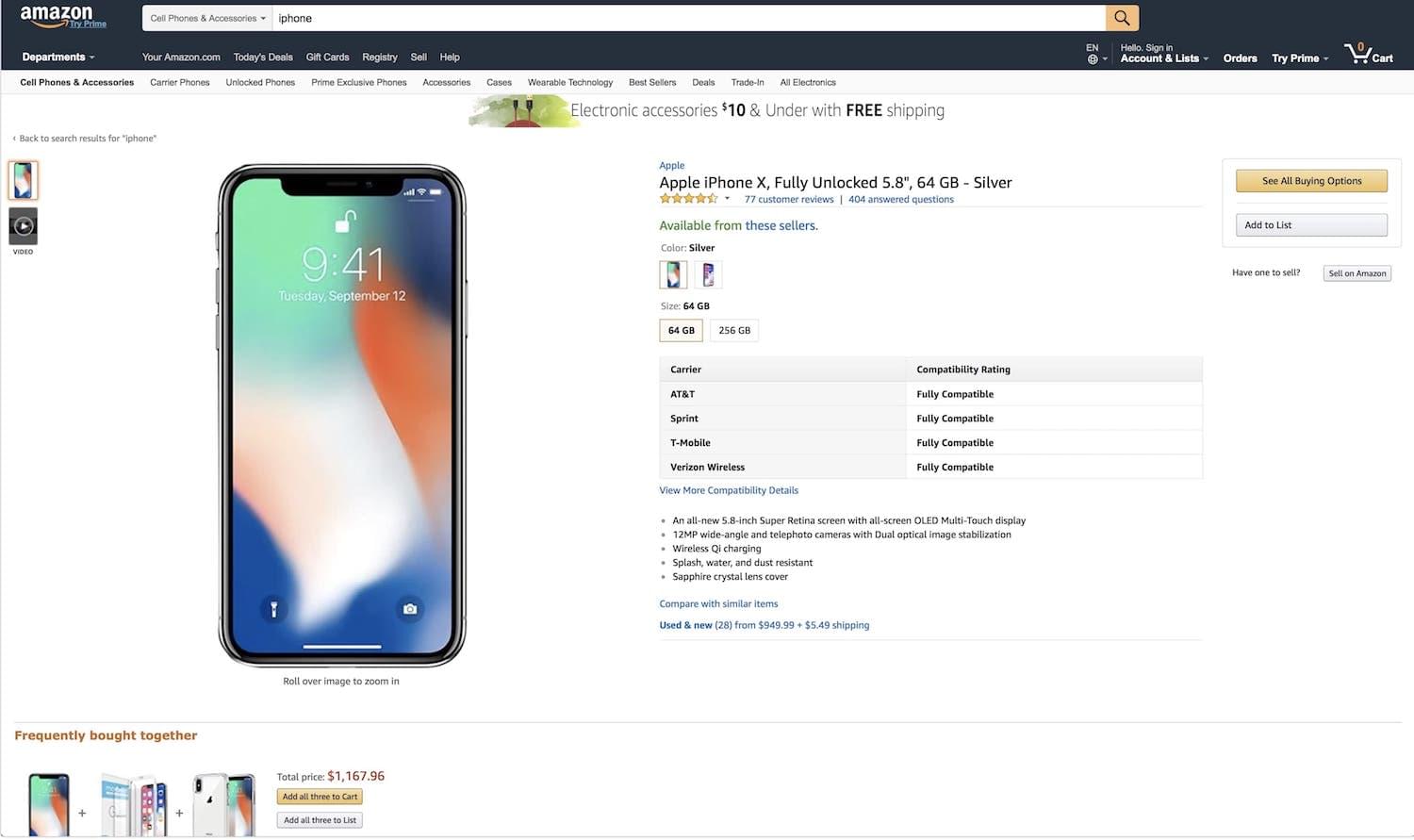

假设我们要在 Amazon.com 上抓取和抓取 iPhone X 的信息; 在今天的日期,这将是产品 URL: https://www.amazon.com/Apple-iPhone-Fully-Unlocked-5-8/dp/B075QN8NDH/ref=sr_1_6?s=wireless&ie=UTF8&sr=1-6

我们如何从crawlbase安全地抓取亚马逊?

我们将首先前往 我的帐户 页面中我们将找到两个令牌,常规令牌和 JavaScript 令牌。

亚马逊的网站不是用 JavaScript 生成的,这意味着它不是在客户端创建的,就像一些使用 React 或 Vue 构建的网站一样。 因此,我们将使用常规令牌。

对于本教程,我们将使用以下演示令牌: caA53amvjJ24 但如果您正在学习本教程,请确保从 我的帐户 页面上发布服务提醒。

Amazon URL 有一些特殊字符,所以我们必须确保正确编码它,例如,如果我们使用 Ruby,我们可以执行以下操作:

1 | 要求 'cgi' |

这将返回以下内容:

1 | https%3A%2F%2Fwww.amazon.com%2FApple-iPhone-Fully-Unlocked-5-8%2Fdp%2FB075QN8NDH%2Fref%3Dsr_1_6%3Fs%3Dwireless%26ie%3DUTF8%26sr%3D1-6 |

伟大的! 我们已准备好用 Crawlbase 抓取 URL。

抓取内容

接下来我们要做的就是提出实际的请求。

Crawlbase API 将在这方面帮助我们。 我们只需向以下 URL 发出请求: https://api.crawlbase.com/?token=YOUR_TOKEN&url=THE_URL

所以我们只需要将 YOUR_TOKEN 替换为我们的令牌(即 caA53amvjJ24 用于演示目的)和 THE_URL 为我们刚刚编码的 URL。

让我们用红宝石来做吧!

1 | 要求 '网络/http' |

完毕。 我们已通过 Crawlbase 向 Amazon 提出了第一个请求。 安全、匿名且不会被阻止!

现在我们应该从 Amazon 返回 HTML,它应该看起来像这样:

1 |

|

抓取网站内容

所以现在只缺少一个提取实际内容的部分。

这可以通过一百万种不同的方式完成,并且始终取决于您正在编程的语言。 我们始终建议使用现有的众多可用库之一。

这里有一些可以帮助您使用返回的 HTML 进行抓取的部分:

用 Ruby 刮擦

使用节点抓取

用 Python 抓取

Crawlbase API 特性和功能概述

Crawlbase API 是一款出色的工具,旨在简化网站抓取过程。 它为用户提供了全面的功能来简化和增强网站抓取。

爬行能力强

该 API 的优势在于其能够抓取多样化的网站,从而允许访问多种数据类型:

- 文本数据提取: 提取文本内容,包括文章、描述以及网页上可用的任何基于文本的信息。

- 图像提取: 检索网页上存在的图像,提供对视觉效果或图形内容的访问。

- 链接收藏: 收集网页上存在的链接,方便导航和访问相关内容。

可定制的配置

其值得注意的方面之一是它在根据您的特定要求定制爬行过程方面提供的灵活性:

- 爬行深度调整: 允许用户设置爬网深度,定义 API 应爬网到网站的深度。

- 爬行频率控制: 提供调整爬网频率的选项,确保根据需要及时、定期更新。

- 数据类型选择: 使用户能够指定要提取的数据类型,确保根据用户偏好进行精确提取。

结构化数据检索

Crawlbase API 专门用于抓取具有组织和结构化数据输出的网站:

- 格式化输出: 以 JSON 或 XML 等结构化格式提供数据,轻松集成到各种应用程序或系统中。

- 数据组织: 确保以有组织的方式检索数据,使其易于解释并准备好集成到您的工作流程中。

附加功能

- 错误处理: 提供强大的错误处理机制,提供有关失败爬网或无法访问数据的详细报告。

- 安全认证: 通过身份验证协议确保对 API 的安全访问,维护数据隐私和完整性。

Crawlbase API 的多方面功能为企业和开发人员提供了强大的资源,支持从网站中高效、结构化地提取各种数据类型。

使用 Crawlbase API 进行网站抓取的好处

Crawlbase API 具有一系列优势,可显着增强网站抓取过程:

1.效率与速度

API 的简化方法加速了数据提取过程,快速从网页收集信息。 它采用高效的算法,确保最佳性能和更快的数据检索。

2. 数据准确性和可靠性

它保证准确可靠的数据提取,最大限度地减少所收集信息中的错误和不准确。 此外,它还确保全面的数据捕获,涵盖网站上提供的各种类型的内容。

3. 可扩展性和灵活性

Crawlbase API 允许抓取网站以进行可扩展的操作,满足单个网站或广泛的网站网络的抓取需求。 此外,它还可以灵活地定制爬行过程,满足数据提取的独特要求。

4. 定制化解决方案

抓取API提供可定制的设置,允许用户根据特定的数据需求抓取网站。 它还可以在爬行网站时进行选择性数据提取,确保检索相关且有针对性的信息。

5. 改进决策和洞察力

它有助于访问全面的数据集,从而根据收集到的见解做出更好的决策。 它还通过爬行网站提供有价值的数据,可用于市场分析、趋势识别和商业智能。

Crawlbase API 通过提供简化、可靠且可定制的数据提取方法来改进您的网站抓取,为您提供有价值的见解和信息,以做出明智的决策。

使用 Crawlbase API 的高级技术

Crawlbase API 提供了先进的技术,可以优化网站抓取过程并满足不同的用例:

- 并行爬行: 利用并行抓取技术,同时从多个网页中提取数据,提高抓取过程的速度和效率。

- 增量爬取: 实施增量爬行策略来识别和仅提取新的或更新的内容,减少冗余并优化数据检索。

- 动态负载处理: 采用方法来处理网站内容的动态加载,确保在动态生成元素的情况下进行全面的数据爬行。

- 定制选择器: 使用自定义选择器从网页中精确定位和提取特定元素,从而实现有针对性的数据抓取。

Crawlbase API 的多功能用例

Crawlbase API 提供了多功能应用程序,其范围超出了抓取网站的简单过程。 其功能超越了传统的网络爬行,满足了一系列与数据相关的需求和不同的行业。

让我们探索多方面的用例,其中 Crawlbase API 成为一个有价值的工具,提供跨不同领域和业务的应用程序:

- 市场调查: 通过抓取网站来获取产品信息、定价数据和消费者评论,进行广泛的市场研究。

- 竞争对手分析: 通过分析和抓取网站、识别趋势和策略,收集有关竞争对手策略的有价值的数据。

- 内容聚合: 聚合新闻网站或博客等不同来源的内容,创建综合数据库或精选提要。

- SEO优化: 爬网网站以提取用于 SEO 目的的数据,包括反向链接分析、关键字研究和网站性能指标,以提高搜索引擎排名。

- 商业智能: 通过抓取网站来收集特定行业的数据,例如财务信息、公司简介或行业趋势,以便做出明智的决策。

Crawlbase API 的先进技术使您能够优化爬行网站并满足各种用例,从市场研究和竞争对手分析到内容聚合和 SEO 优化。

使用 Crawlbase API 进行高效爬网的策略

抓取网站需要采用智能策略来最大限度地发挥 Crawlbase API 的潜力。 这些技术可确保您有效地抓取最有价值和相关的数据:

- 优化您的查询: 通过指定所需的确切数据来优化查询,从而减少不必要的负载和时间。

- 利用爬网调度: 利用API的调度功能,在非高峰时段执行爬虫,保证性能的流畅。

- 实现增量爬取: 通过采用增量爬取技术来关注新的或修改的数据,减少冗余数据收集。

- 使用自定义提取器: 在抓取网站时使用自定义功能来精确定位和检索特定数据点,从而提高效率和准确性。

- 优雅地处理速率限制: 通过确保稳定的爬网速度来战略性地管理速率限制,防止因过多请求而造成中断。

您可以在抓取网站时使用这些策略以实现完美优化。 当您遵循它们时,Crawlbase API 可以帮助您顺利抓取网站并有效地获取所需的数据。

应对爬行过程中的各种挑战

应对网站抓取过程中经常出现的复杂问题可能具有挑战性,但通过正确的方法,您可以无缝克服这些障碍。

以下是处理各种复杂性的一些建议:

- 动态内容: 采用动态渲染技术来捕获通过 JavaScript 加载的内容,确保甚至从动态页面中也能进行全面的数据提取。

- 验证码和防抓取机制: 实施策略来规避反抓取措施,例如代理或验证码解算器,保持不间断的抓取过程。

- 强大的错误处理: 开发强大的错误处理机制来管理连接超时、服务器错误或中断,确保爬网更顺畅。

- 处理复杂的页面结构: 自定义爬虫以解释和导航复杂的页面结构,确保从复杂的布局中准确提取数据。

- 避免 IP 封锁: IP地址轮换,实施IP轮换策略,防止爬取操作时被网站屏蔽或限制。

底线!

在本博客中,我们探索了 Crawlbase API 用于抓取网站的不同功能。 它提供了一种动态且全面的网站爬行方法。

我们还公开了有效抓取网站的各种技术和策略。 如果您刚刚开始抓取网站,我们已经提到了您可能面临的复杂情况以及处理这些问题的最佳方法。 有了所有这些信息,现在您已经了解了仔细爬行网站的重要性和用例。

数据无疑是现代企业的氧气,因此,了解爬行网站以收集准确可靠的数据非常重要。 Crawlbase API 凭借其超强的功能、可定制的解决方案以及专家级的复杂性处理,成为企业、研究人员和数据爱好者的重要工具。 其在数据提取和处理各种爬行挑战方面的敏捷性和效率表明了其对于获取有价值的数据并在竞争中保持领先地位的重要性。

我们希望你喜欢这个教程,我们希望很快见到你 爬虫库. 快乐爬行!