在过去,数据研究人员不得不努力找出他们为特定目的所需的相关信息。 由于互联网包含结构化、非结构化或半结构化的动态数据,因此可以在网页、博客文章、研究文章、HTML 表格、图像、视频等中获得这种定性信息。因此,这是一项耗时的任务当他们不得不手动完成时。

引入网络抓取以简化数据的手动搜索,并已被证明是全球社会科学家的福音。 网页抓取 是一个通过使用机器人过程自动化技术或 Web 抓取 API 自动获取在线可用数据的过程,这些 API 也为您的 Web 浏览器提供代理。

通过机器人过程自动化 (RPA) 进行网页抓取

机器人流程自动化 (RPA) 是一种用于有效、更快地执行重复性任务的技术。 您还可以通过准备 RPA 程序从在线来源搜索特定信息来进行网络抓取。 该RPA程序可以将抓取的数据编译成文档以供进一步使用。 实施RPA 是一种超级有效的方法,但由于一些原因不推荐;

- 它以相同的重复研究方式工作。

- 网站可以阻止 RPA 网络抓取程序,因为它会一次又一次地打开以进行数据抓取。

- 对于看起来类似于 UI(用户界面)元素的 Web 界面是可行的

- 它增加了系统的负载。

通过 Web Scraping API 进行 Web Scraping

专门开发的应用程序编程接口 (API) 可以轻松地从可用的在线资源中抓取网络数据,这是最可靠的数据抓取方式。

网页抓取API 通过允许您最可靠、最流畅地进行网络抓取,提供在两个网站之间进行通信的中介来源。 Web 抓取 API 允许您以创新的方式从动态 Web 资源中自动检索数据。

避免被阻塞的方法

高效且创新的 Web 抓取 API 是用于从任何在线来源自动获取数据的 Web 服务。 它也是最具成本效益但最省时的方法。

但是在这个现代计算时代,所有在自动化框架上工作的技术都需要仔细注意,以免被网站屏蔽。 如果您在实施网络抓取技术时不注意这些方式,则数据抓取的检测很容易。

1. Scraping API 的实现以避免 CAPTCHA 块

CAPTCHA 这个词代表完全自动化的公共图灵测试,旨在检测访问特定站点的用户是用于进行有害目的的网络钓鱼的机器人,还是接近该网页上某些可用数据的普通用户。

许多网站都集成了算法来识别以区分站点的人类和机器人访问者。 阻止 Web 抓取 API 具有内置方法来处理可能阻止 Web 数据抓取的动态技术。 通过使用动态基础设施设置各种代理,抓取 API 可以轻松集成到您的应用程序中。 他们还负责处理可能会妨碍您的网络抓取过程的验证码。

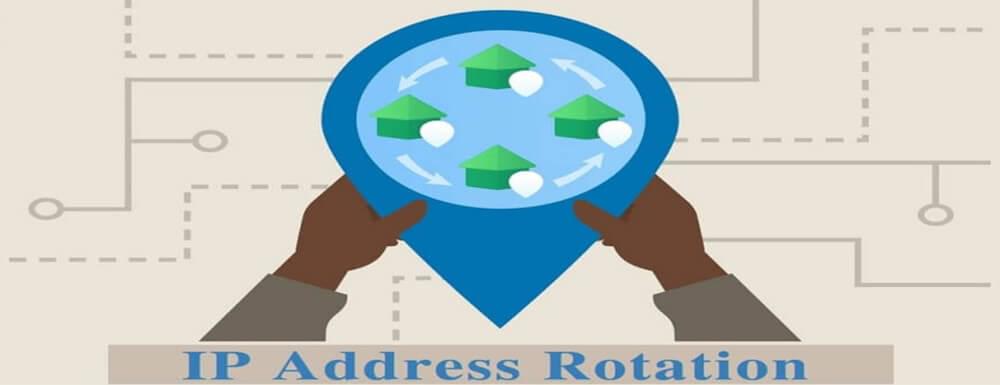

2.利用轮换IP地址

IP 地址用于识别和查找所有连接到 Internet 的设备。 明确地说,IP 地址有两种类型,即 IPv4 和 IPv6。 使用分配的 IP 地址以不同的计划或非计划时间间隔分配给设备的过程称为 IP 轮换。 利用定期轮换的 IP 地址是一种行之有效的方法,可以避免在从 Web 源中抓取数据时被阻止。

通过 ISP(Internet 服务提供商)的活动连接已经从 IP 池连接。 当发生连接和断开连接时,ISP 会自动分配另一个可用的 IP 地址。 互联网服务提供商用于轮换 IP 地址的不同方法如下:

- 预配置的 IP 轮换: 在这种方法中,预先构建了以固定时间间隔发生的轮换,其中,当固定时间过去时,新的 IP 地址已经分配给用户

- 指定的 IP 轮换: 在这种方法中,用户选择 IP 地址进行大量连接

- 随机 IP 轮换: 在这种方法中,用户无法控制为每个传出连接分配随机、轮换的 IP 地址

- 突发 IP 轮换: 新的IP地址在指定的数字后分配给用户,通常是10个。第十一次连接将获得一个新的IP地址

轮换 IP 地址是一种避免被阻止请求的熟练且经过验证的方法。

3.设置辅助请求标头

请求和响应消息是 HTTP(超文本传输协议)的标头部分组件的一部分。 它们定义了 HTTP 事务的操作参数。 通过创建和配置辅助请求标头,您可以确定您希望如何将内容提供给用户,并避免在网络抓取期间出现任何阻塞。

4. 警惕蜜罐陷阱

网络抓取最重要的规则是让您的努力尽可能不显眼。 这样,您就不必面对来自您选择的目标网站的任何猜测或可疑行为。 为此,您需要一个组织良好、运行有效且灵活的网络抓取程序。

远离蜜罐陷阱的措施:

您可以使用一些基本措施来避免在阻止网络抓取期间出现任何阻止请求,并远离蜜罐陷阱;

i. 检查条款和条件:

您需要做的第一件重要的事情是通过访问他们的条款和条件,确保您要抓取的网站有任何对网络抓取有害的内容。 如果有任何关于不喜欢网络抓取的事情,请停止抓取他们的网站,这是您解决这个问题的唯一方法。

II。 负载最小化:

考虑减少您尝试抓取的所有网站的负载。 通过持续加载网站可能会使他们对您保持谨慎。 为您打算抓取数据的每个网站或网页仔细进行负载最小化。

在网站上施加高负载可以提醒他们您抓取他们网站的目的,这可能会给您带来问题。 所以,请注意这一点。 您可以使用多种方法和技术来减少指定网站的负载。 其中一些在下面提到:

a. 尝试缓存和存储之前抓取的网站页面的URL,确保不需要再次加载,最大限度地减少网站的负载

b. 尝试慢慢工作,不要同时发送多个请求,因为这会给资源带来压力

c. 适当地做你的刮,刮你需要的内容。

III。 合适的网页抓取工具使用:

您使用的块网络抓取工具应该区分其措施,转换其抓取模式并为网站呈现积极的面貌。 因此,通过这种方式,您不会遇到让他们产生防御性和过度敏感的问题或令人担忧的情况。

IV。 使用代理 API:

对于网络抓取,请使用多个 IP 地址。 您还可以使用代理服务器和 VPN 服务或 爬虫库 API 对此也很有效。 代理在从 Web 源抓取数据时避免被阻止的威胁非常有效。

v. 通过访问“robots.txt”避免蜜罐陷阱:

必须查看“robots.txt”文件。 它将帮助您深入了解网站的各自政策。 这里提到了与网络抓取相关的所有细节。 详细信息包括允许您抓取的确切页面。 以及每个页面请求之间的先决条件间隔。

通过理解并遵循这些说明,您可以避免并减少从您想要抓取的网站所有者那里获得任何阻止请求和风险的机会。

5. 不规则时序的动态抓取模式

如果您想在没有任何阻塞的情况下进行网页抓取,请使用具有不同不规则时间和间隔的动态抓取模式。

人们普遍注意到,当使用 RPA 等机器人完成特定的网络抓取任务时,它们会遵循经过特殊训练的特定模式。 但是如果典型的用户访问一个网页,他将有动态的访问时间,不同的搜索模式来找到他想要的数据。 通过实施块网络抓取 API 可以将相同的逻辑应用于网络抓取,以避免被阻止的请求。

结语

上面的文章都是关于与您在块网络抓取过程中可能面临的陷阱和障碍问题相关的不同场景。 上面讨论的方法将帮助您有效地考虑以智取和合乎逻辑的方式来克服困难并避免在网络抓取期间获得阻止的请求。

通过了解并遵循网络抓取规则,您可以轻松地从任何可用的在线资源中抓取所需的信息。 此信息可以在许多方面有所帮助,并且可以用于动态目的。