A 网页抓取工具 是一款出色的数据挖掘软件,主要由数据挖掘者和分析师用来通过万维网收集大数据集。 它是一种利用高效的数据挖掘技术来自动化网页抓取过程的工具,否则这是不可能手动完成的。 随着通过网络抓取进行数据收集对于大多数企业来说变得越来越重要,对更好的网络抓取工具的需求也变得必要。 因此,在本文中,我们将讨论网络抓取工具的相关性,以及即使没有任何技术或编程技能,如何在您的项目中使用这个神奇的工具。

数据挖掘简而言之

在深入研究网络爬虫之前,让我们简要讨论一下数据和数据挖掘。 “数据挖掘”一词,也称为“数据库中的知识发现”,是 1990 世纪 XNUMX 年代初创造的,是通过大量数据收集或挖掘数据以识别可用于预测未来课程的模式和联系的过程。 数据挖掘的基础知识包括多个科学学科,包括分析和统计学。 然而,随着我们的技术不断进步, 人工智能和机器学习 在大数据挖掘过程中发挥了重要作用。

根据研究截至 64.2 年,全球生成的数据总量已达到 2020 ZB,并且数据创建量将继续增长,并在未来五年内增长两倍。 这就是为什么网络抓取或数据挖掘的自动化至关重要。 如果没有它,您将无法利用大量可用资源,因为在合理的时间内为您的任何工作收集有价值的数据都将很困难。

Web Scraper - 一种现代的挖矿工具

在当今时代,如果您想进行市场研究并制定最佳业务策略,您将需要数据。 收集大量数据并访问相关信息的最有效方法是通过网络抓取。 术语“网络抓取”是指从目标网站提取任何数据。 收集到的信息随后用于各种用途,例如数据分析、营销研究、SEO 活动等。 网络抓取工具只是一个允许网络抓取自动化的工具。

现在听起来可能非常简单,但事实是抓取网站并不是一件容易的事。 你看,大多数网站都不喜欢机器人爬虫以任何理由重复访问其内容。 如今几乎所有网站都有某种机器人检测程序或算法,可以立即阻止任何可疑活动,而网络抓取工具可以轻松触发此类安全措施。 这就是为什么选择最合适的抓取工具将显着影响您的数据挖掘成功。

选择正确的网页抓取工具 - 需要考虑的事项

当有人希望通过互联网提取有价值的数据时,您将需要一个能够有效完成任务的工具。 网页抓取是一项资源密集型工作,如果不正确了解寻找抓取工具时需要考虑哪些因素,可能会很棘手。 做出决定时需要记住几件事,因此我们列出了一些有意义的见解。

便于使用 - 您首先需要网络爬虫的原因之一是它提供的功能以及它如何让您的生活更轻松。 在查看数据挖掘工具列表并选择不会浪费时间关注如何使用该工具的工具时,这是要考虑的最重要因素之一。 它应该有详细记录并且简单明了。

可扩展性- 如果您计划为任何项目抓取大量数据,则必须使用高度可扩展的工具。 在线可用的数据量只会随着时间的推移而增加,因此如果您想在未来扩展,您选择的数据挖掘软件应该易于扩展是有意义的。

代理质量 - 作为数据挖掘者或分析师,您必须警惕 CAPTCHA 和其他 机器人检测算法 由网站部署,因为它们会阻止您实现目标。 验证码用于阻止机器人和网络爬虫通过自动化从一个来源发送过多的请求,并且可以有效地绕过或避免使用旋转代理。

定价透明度 - 就像任何其他服务一样,定价结构是一个重要的方面。 在注册之前,用户应该知道额外的费用。 作为服务的提供者,这些 费用应向所有客户披露。 对于大多数人来说,设置自己的网络爬行工具是一项乏味的任务,而且成本高昂。 大多数企业也更愿意利用其他公司的代理服务来实现他们的目标 网络爬虫。 因此,找到价格合理的合适数据挖掘软件始终是必须的。

客户支持 - 它不是工具的实际功能,而是使用服务或产品时整体体验的重要组成部分。 如果任何企业想要拥有成功的产品或服务,那么这是一个必要的功能。 作为客户,您应该拥有良好的客户支持体验,尤其是使用网络抓取工具等数据挖掘工具,其中大部分功能都位于后端,通常需要技术知识来排除故障。

适合初学者的流行网页抓取工具和服务

虽然你可以 构建自己的网络爬虫 从头开始,不可否认的是,使用现成的网络抓取工具对于大多数用户来说会更加方便。 尽管如此,我们还是列出了抓取行业中几种著名的数据挖掘工具(排名不分先后),它们非常适合初学者或不具备创建自己的抓取工具的技术技能的人。

- 阿皮菲—— 提供用于爬行和抓取网站的现成工具。 Apify 可以自动执行您在网络浏览器中手动执行的大多数任务,并根据您的需求进行扩展。 Apify 还为特定用例提供了广泛的数据挖掘工具,例如社交媒体网站的抓取工具、Google SERP、SEO 审核工具、通用网络抓取工具等。 在定价方面,他们为所有用例提供相当灵活的计划,包括为自由职业者、小型项目开发人员和学生提供理想的订阅计划。

- Brightdata 的数据收集器 - 完全自动化的网络数据提取工具。 该数据收集工具拥有非常直观且易于理解的用户界面,同时可以准确地从任何网站收集数据。 您可以选择使用预构建的收集器模板或使用 Chrome 扩展创建自定义收集器。 然而,您从他们的工具中获得的功能比我们这里的大多数示例具有更高的溢价。 它的价格仍然合理,因为您是为他们产品的整体便利性付费的。

- ScrapeHero 的网络爬虫服务 - 如果您想将自动化提升到一个新的水平,他们的抓取服务可能是您的最佳选择。 它完全消除了设置服务器或软件来抓取任何数据的需要,因为它将提供网络抓取服务并为您完成一切。 这个数据挖掘软件只需要你告诉他们你需要什么数据,他们会管理从数据收集到交付的整个过程。 由于这是一项几乎不需要用户做出任何努力的服务,因此预计定价会处于较高水平。

- 八分法 - 当您的项目预算紧张且编码时零线索? Octoparse 的数据提取工具可能就是您正在寻找的解决方案。 他们有一个带有点击界面的可下载应用程序,因此您不必担心在网络上提取各种数据集的代码行。 只需三个简单的步骤,您就可以开始数据收集。 定价非常有竞争力,其中包括对所有应用程序功能的慷慨访问。

- Crawlbase 的 Scraper API - 它是当今市场上最实惠的刮擦工具之一。 它是一个简单的数据提取 API,构建在数千个旋转代理之上,可以在几秒钟内快速抓取、抓取和交付您需要的数据。 然而,与大多数人不同 数据挖掘工具 这里提到,Scraper API 没有本地 UI,您可以在其中指向并单击内容来执行命令。 相反,API 依赖于其简单但有效的数据提取方法及其轻松集成到任何现有系统中的能力。

使用 Web Scraper 提取数据

现在我们已经讨论了如何根据您的需求选择最佳数据挖掘软件的几点建议,让我们向您展示一个如何利用抓取工具从网站提取数据的好例子。对于这个例子,我们将使用 Crawlbase 的 刮板API 来证明这个过程是多么简单。 Scraper API 不需要您具备编码方面的高级知识即可有效地使用它。 API 可以单独使用,也可以通过网络浏览器或终端通过三个简单的步骤执行。

第 1 步:创建您的帐户并获取 API 密钥。

在创建新帐户 爬虫库 获取您的 1,000 个免费 API 请求。 去你的 帐户的仪表板 然后复制您的私人令牌。

第 2 步:了解 Scraper API 的基础知识。

进行第一个 API 调用非常简单。 您只需要记住 API 的基本端点以及插入您想要抓取的网站 URL 的位置即可。 为了更好地理解它,我们将其分为三个部分:

Scraper API 端点:

https://api.crawlbase.com/scraper

您的私钥或令牌:

?token=API_KEY

目标网址:

&url=encodedURL

如果你不熟悉如何编码 URL,你可以简单地使用这个 URL 解码器/编码器页面.

作为一种良好的做法,始终建议阅读产品 文件 在使用它之前。

第 3 步:进行第一个 API 调用。

将调用的所有部分组合在一起后,您现在可以将请求发送到 API,并让它为您完成其余的工作。 下面是带有编码 URL 的 Scraper API 调用的完整示例:

1 | https://api.crawlbase.com/scraper? |

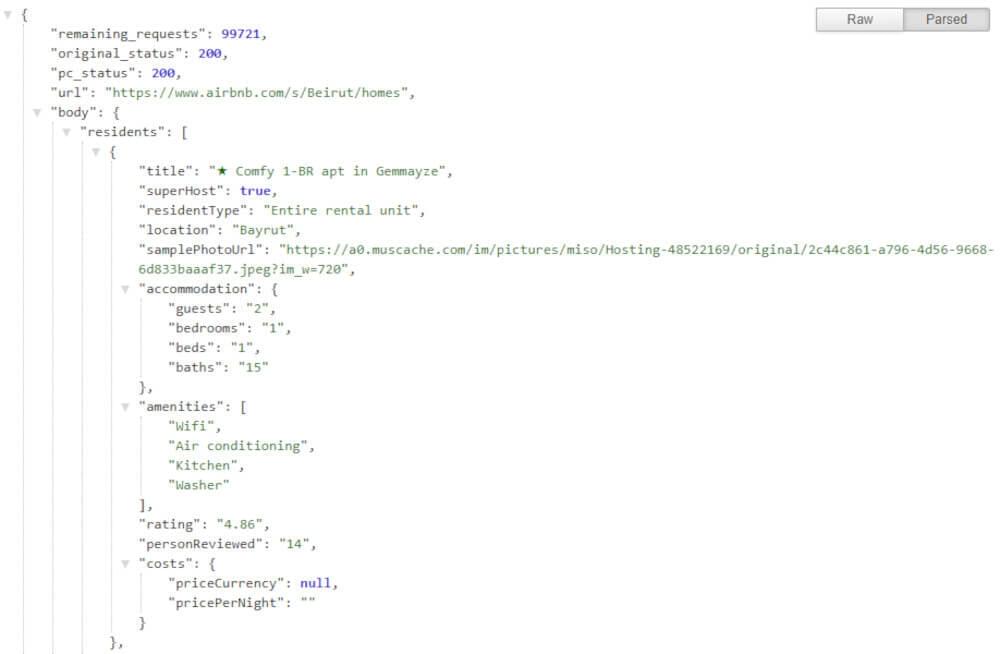

这可以通过多种方式执行,但通过浏览器发送是最简单的。 只需复制该行,将其粘贴到地址栏中,然后按 Enter 键即可。 您将在几秒钟内自动获取网站的解析内容,如下面的示例输出所示:

由于 Scraper API 具有高度可扩展性,因此可以很容易地在其之上构建完全自动化的网络抓取器或将其集成到任何现有系统或应用程序中。 Crawlbase还提供了广泛的 库和 SDK 帮助用户扩展或集成 API。

为您的企业简化数据挖掘的用例

高效且 简化数据挖掘 可以为从企业到政府部门和医疗保健提供者的一系列行业和组织提供帮助。您还可以通过以下方式了解简化数据挖掘对您的业务的影响 Illumeo 的数据挖掘课程 – 利用洞察力并提升决策水平。以下是一些应用 数据挖掘:

了解您的客户并改善服务

数据挖掘可以帮助公司提取和分析客户的信息,了解他们喜欢什么、如何购物以及做什么。 这有助于他们制作更好的广告,创造新的产品来销售,并使客户更满意,以便他们不断回来。

数据挖掘有助于发现欺诈行为

数据收集工具就像寻找信用卡、保险和身份盗窃诈骗的侦探。 它着眼于人们如何使用他们的卡和钱,并能发现奇怪的事情。 这有助于公司抓住坏人并在欺诈发生之前阻止欺诈。

供应链工程

数据挖掘可以使供应链更好地运作。 它可以帮助公司找到工作效率不高的地方并使其变得更好。 这意味着事情可以更快地完成,而且成本也不会很高。 现在有许多数据挖掘工具可以帮助公司利用数据挖掘来发挥其优势。

选择合适的商业地点

数据收集帮助公司找到商店、办公室和仓库的最佳地点。 它会查看数据量并使用“位置智能”来确定最佳位置。 例如,它可以显示大多数客户从哪里订购,以便公司知道在哪里设立仓库。 它还会考虑有多少人住在那里、他们赚了多少钱以及附近有哪些其他企业,以帮助选择完美的位置。

预测未来以实现更好的业务

每个企业都需要正确管理其资源,因为资源过多或过少都可能是一个大问题。 这就是数据分析的用武之地——它可以帮助企业预测他们未来的需求。 他们使用数据挖掘从过去提取必要的信息来创建可以告诉他们接下来会发生什么的模型。 这有助于他们在做什么和把钱投资到哪里方面做出更明智的选择。

结论

数据挖掘不必很复杂。 目前市场上有很多数据挖掘工具可供任何人使用,无论其技术技能如何。 作为个人,您只需了解每种产品的功能即可找到最适合您需求的产品。

如果您仍然有疑问或希望了解更多信息,我们强烈建议您亲自尝试一下。只需注册试用即可免费测试许多用于数据收集的工具。那么,为什么不继续测试一下呢? Crawlbase 提供 只需注册即可获得 1,000 个免费请求。 这些请求应该足以帮助您开始抓取工作。