获取实时数据是当代众多企业和研究人员的命脉。 无论您是跟踪市场趋势、监控竞争对手价格还是进行学术研究,从沃尔玛等电子商务巨头获取数据都可以提供宝贵的见解。 网络抓取是打开这个信息宝库的关键。 将其与无头 Firefox 结合起来 硒 和爬行基地 智能代理 为更高效和有效的数据收集打开了大门。

在这份综合指南中,我们将带您踏上网络抓取世界的旅程,重点关注抓取的复杂性 沃尔玛 产品页面使用 蟒蛇 编程语言。 我们将为您提供应对 IP 块、验证码和动态内容带来的挑战所需的知识和工具。 在本指南结束时,您将能够利用无头 Firefox Selenium 的全部潜力和智能代理来抓取沃尔玛的广泛产品列表。

无论您是经验丰富的数据科学家、业务分析师,还是只是渴望探索网络抓取世界的人,本指南都是您成功的路线图。 因此,请系好安全带,我们将踏上数据驱动的冒险之旅,让您能够提取、分析和利用来自全球最大在线零售商之一的数据。

目录

- 什么是硒?

- 什么是智能代理?

- 为什么使用带有智能代理的无头 Firefox Selenium 来抓取沃尔玛产品页面?

- 可以绕过 IP 块和验证码

- 可以抓取更多页面而不被禁止

- 可以获得更准确、一致的结果

- 可以运行得更快并且使用更少的资源

- 安装 Firefox、Python,并下载 Firefox Geckodriver

- 安装 Selenium 和随机用户代理库

- 从 Crawlbase 等提供商处获取智能代理

- 配置 Selenium Firefox 驱动程序以使用智能代理

- 以无头模式启动 Firefox 并查看 IP

- 了解沃尔玛产品页面结构

- 从沃尔玛页面 HTML 中抓取重要数据

1. 简介

在快节奏的网络抓取和数据提取领域,Selenium、无头 Firefox 和智能代理的组合已成为强大的三重奏。 本介绍通过定义这些关键组件并阐明为什么它们的融合对于抓取沃尔玛产品页面至关重要,为我们的探索奠定了基础。

什么是硒?

Selenium 是一种强大的自动化工具,广泛应用于 Web 开发和测试。 它允许我们以编程方式控制网络浏览器,模仿人类与网络元素的交互。 Selenium 本质上使我们能够导航网站、与表单交互以及无缝提取数据。

什么是智能代理?

智能代理是一种动态解决方案,可充当网络抓取应用程序和目标网站之间的中介。 与静态代理不同,智能代理拥有有效轮换和管理 IP 地址的智能。 它们在克服 IP 禁令和验证码等障碍方面发挥着关键作用,这使得它们对于大规模网络抓取操作不可或缺。

为什么使用带有智能代理的无头 Firefox Selenium 来抓取沃尔玛产品页面?

作为世界上最大的零售商之一,沃尔玛拥有广泛的在线业务和丰富的产品信息。 然而,抓取如此庞大的电子商务平台也面临着挑战,包括反抓取措施。 沃尔玛采用 IP 封锁和验证码等措施来阻止网络爬虫。 我们利用无头 Firefox Selenium 和智能代理来克服这些障碍并有效地提取数据。

在下一节中,我们将深入探讨此设置的好处,重点介绍它如何增强网页抓取过程。

2. 使用带有智能代理的无头 Firefox Selenium 的好处

现在我们了解了基础知识,是时候深入研究使用无头 Firefox Selenium 与智能代理来抓取沃尔玛产品页面的优势了。 这种强大的组合提供了一系列好处,使其成为网络抓取爱好者和专业人士的首选。

可以绕过 IP 块和验证码

与许多其他网站一样,沃尔玛采用 IP 阻止和验证码等安全措施来阻止自动抓取。 当与智能代理配合使用时,Headless Firefox Selenium 可以无缝绕过这些障碍。 智能代理会轮换 IP 地址,这使得识别和阻止抓取活动对网站来说具有挑战性。 这确保了不间断的数据收集,即使是来自 IP 限制的来源。

可以抓取更多页面而不被禁止

传统的抓取方法经常会因为短时间内产生大量请求而导致 IP 封禁。 凭借其类似浏览器的行为和智能代理的 IP 轮换,Headless Firefox Selenium 允许抓取大量页面而不触发禁令。 在处理沃尔玛或类似平台上的大量产品目录时,这种可扩展性是非常宝贵的。

可以获得更准确、一致的结果

抓取电子商务数据时,准确性至关重要。 Headless Firefox Selenium 可以像人类用户一样渲染网页,确保检索到的数据准确且最新。 智能代理通过保持请求的一致性来提高这种准确性,减少接收倾斜或不完整信息的机会。

可以运行得更快并且使用更少的资源

效率很重要,尤其是在大规模铲运作业中。 Headless Firefox Selenium 是一款无头浏览器,比传统浏览器消耗更少的系统资源。 这会带来更快的抓取速度、降低的服务器成本以及更灵活的数据提取过程。 当与智能代理的智能 IP 管理相结合时,抓取操作变得更快且资源效率更高。

在接下来的部分中,我们将指导您完成使用智能代理设置无头 Firefox Selenium,然后进行抓取沃尔玛产品页面的实际演示。 随着我们深入研究网络抓取的世界,这些好处将变得更加明显。

3. 如何使用智能代理设置 Headless Firefox Selenium

现在我们已经探索了这些优点,让我们深入了解设置无头 Firefox Selenium 和智能代理来抓取沃尔玛产品页面的实际步骤。 此过程涉及几个关键部分,我们将指导您完成每个部分。

安装 Firefox、Python 并下载 Firefox Geckodriver

要使用智能代理设置无头 Firefox Selenium,您需要确保系统上安装了必要的软件和驱动程序。 以下是有关如何执行此操作的详细指南:

安装火狐浏览器:

Mozilla Firefox 是 Selenium 将用于 Web 自动化的 Web 浏览器。 您可以从 火狐官方网站。 确保下载与您的操作系统兼容的最新稳定版本。

安装Python:

Python 是一种主要用于编写 Selenium 脚本的编程语言。 大多数操作系统都预装了 Python。 但是,系统上必须安装 Python。

要检查 Python 是否已安装,请打开终端或命令提示符并键入:

1 | python --version |

如果没有安装Python,可以从以下地址下载: Python官方网站。 下载适合您的操作系统的最新稳定版本。

下载 Firefox Geckodriver:

Geckodriver 是 Selenium 与 Firefox 交互的关键组件。 它充当 Selenium 和 Firefox 浏览器之间的桥梁。 要下载 Geckodriver,请按照下列步骤操作:

浏览 Geckodriver 发布页面 在GitHub上。

向下滚动到标有“资产”的部分。

在资产下,您将找到适合您的操作系统的最新版本的 Geckodriver(例如

geckodriver-vX.Y.Z-win64.zip对于 Windows 或geckodriver-vX.Y.Z-linux64.tar.gz对于 Linux)。 下载合适的版本。下载后,将 ZIP 或 TAR.GZ 文件的内容解压到计算机上的目录中。 记下此目录的路径,因为您将在 Python 脚本中需要它。

安装 Selenium 和随机用户代理库

Selenium 是一个用于自动化 Web 交互的强大工具,它是我们 Web 抓取设置的核心。 使用 Python 的包管理器 pip 使用以下命令安装 Selenium:

1 | 点安装硒 |

此外,我们将使用一个名为“随机用户代理”的库来为 oupip 安装 seleniumr 浏览器生成随机用户代理字符串。 也使用 pip 安装它:

1 | pip 安装随机用户代理 |

从 Crawlbase 获取智能代理

Crawlbase 提供一系列网络抓取解决方案,包括与 Selenium 兼容的智能代理。 打开您的网络浏览器并导航至 抓取基地网站.

如果您是新用户,则需要在 Crawlbase 上创建一个帐户。 单击“注册”或“注册”按钮提供所需信息。 登录后,您可以在此处找到您的智能代理 URL。Crawlbase 代理 URL 将如下所示。

1 | http://[电子邮件保护]:8012 |

Crawlbase 根据您的网络抓取需求提供各种代理计划。 查看更多有关 Crawlbase 代理计划。 这些计划可能在可用代理的数量、位置和其他功能方面有所不同。 作为一个良好的开端,Crawlbase 提供了一个月的免费试用(功能有限)。 查看可用计划并通过阅读选择最适合您的要求的计划 Crawlbase 智能代理文档.

配置 Selenium Firefox 驱动程序以使用智能代理

现在,让我们配置 Selenium 以使用智能代理。 要在 Python 脚本中使用带有 Selenium Firefox 驱动程序的 Crawlbase 智能代理,请使用所需名称创建一个 Python 脚本,并向其中添加以下代码:

第 1 步:导入必要的库

1 | 进口 os |

说明:

在这里,我们导入所需的 Python 库和模块。 其中包括用于 Web 自动化的 Selenium、用于生成随机用户代理的 random_user_agent 以及用于配置 Firefox 浏览器的其他内容。

第 2 步:生成随机用户代理

1 | user_agent_rotator = UserAgent( |

说明:

在这里,我们为 Firefox 浏览器创建一个随机用户代理。 用户代理有助于模仿不同的网络浏览器和平台,使您的抓取活动看起来更像常规用户行为。

第 3 步:配置 Firefox 选项

1 | firefox_options = 选项() |

说明:

在这一部分中,我们为Firefox浏览器设置各种选项。 例如,我们让它以无头模式运行(没有可见的 GUI)、设置窗口大小、禁用 GPU 使用以及应用之前生成的随机用户代理。

第 4 步:定义您的智能代理 URL

1 | 代理主机= “http://[电子邮件保护]" |

说明:

在此部分中,您应该将 YourAccessToken 替换为从 Crawlbase 获取的令牌。 此 proxy_host 和 proxy_port 将用于通过智能代理路由您的 Web 请求。

第 5 步:为 Firefox 设置智能代理

1 | firefox_options.set_preference(“网络.代理.类型”, 1) |

说明:

本节为 Firefox 设置代理服务器。 第一行将代理类型设置为 1,即“手动代理配置”。 接下来的八行设置 HTTP、HTTPS (SSL)、FTP 和 SOCKS 连接的代理服务器主机和端口。 最后一行禁用 HTTP 连接的缓存。

步骤 6:指定 Firefox Geckodriver 路径

1 | fireFoxDriverPath = os.path.join(os.getcwd(), “司机”, “壁虎司机”) |

说明:

此行指定 Firefox Geckodriver 可执行文件的路径。 确保提供系统上 Geckodriver 文件的正确路径。

第 7 步:使用配置的选项创建 Firefox 驱动程序

1 | firefox_service = 服务(fireFoxDriverPath) |

说明:

此行指定 Firefox Geckodriver 可执行文件的路径。 确保您提供系统上 Geckodriver 文件的正确路径。

以无头模式启动 Firefox 并验证 IP

要检查代理是否正常工作以及您的 IP 是否通过它路由,您可以使用一个简单的示例。 我们将向 http://httpbin.org/ip URL 并显示 HTML 正文中返回的代理 IP。 在上一步中创建的脚本末尾添加以下代码。

1 | # 访问http://httpbin.org/ip URL查看IP是否发生变化 |

在这段代码中,我们使用 Selenium 的 driver.get() 方法导航到 http://httpbin.org/ip URL,我们打算在其中收集有关 IP 地址的信息。

在 try 块中,我们结合使用 Selenium 的 WebDriverWait EC.presence_of_element_located。 这种组合允许我们等待标记为“body”的 HTML 元素的出现。 为了确保我们不会等待太久,我们在 WebDriverWait 中设置满足条件的最大等待时间(以秒为单位),定义为 time_to_wait。 此步骤对于确保网页确实已完整加载至关重要。

网页完全加载后,我们使用以下命令提取其 HTML 源代码 drver.page_source 方法。 获取 HTML 后,我们从 HTML 正文中定位并检索 IP 地址。 我们通过搜索“body”标签并提取其文本内容来实现这一点。

样本输出:

1 | { |

通过执行以下步骤,您可以在无头模式下启动 Firefox,访问 URL 以检查 IP,并验证您的请求确实是通过智能代理路由的。

4. 抓取沃尔玛产品页面的实际示例

本节将深入研究使用无头 Firefox Selenium 和智能代理从沃尔玛产品页面抓取有价值数据的实际示例。 我们将为您提供代码并引入一个有价值的函数来简化抓取过程。

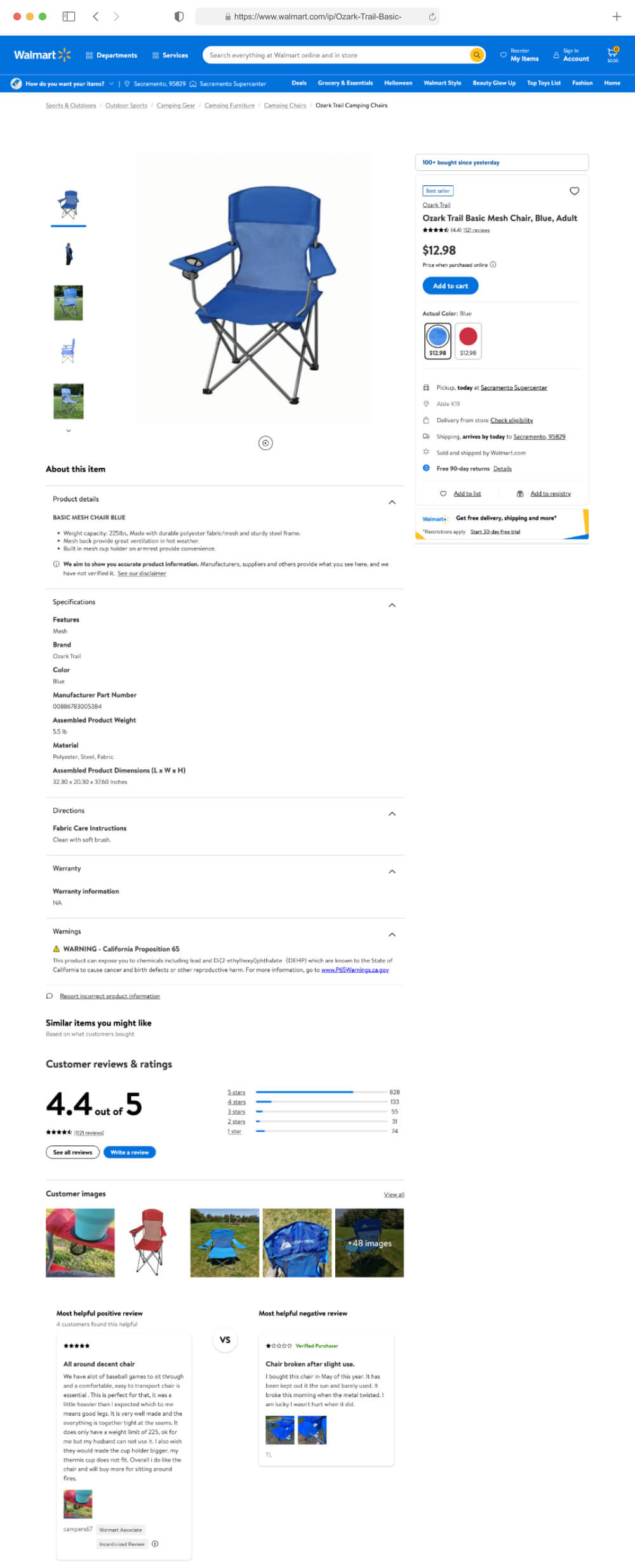

了解沃尔玛产品页面结构

要成功从沃尔玛产品页面抓取数据,理解页面 HTML 的底层结构至关重要。 沃尔玛的产品页面组织良好,包含有价值的信息,例如产品名称、价格、描述、评论等。

要从沃尔玛产品页面抓取重要信息,您可以检查沃尔玛页面 HTML 并找到存在所需信息的元素的唯一选择器。 让我们分解一下基本要素以及如何识别它们以进行抓取:

- 产品名称: 产品标题通常是页面上最突出的元素,通常位于 id 为 h1 HTML 元素内

main-title。 我们可以使用XPath表达式'//h1[@id="main-title"]'准确定位这个标题。 - 产品价格: 产品价格是另一个重要信息。 它通常可以在包含带有名称的数据属性的 span HTML 元素中找到

testid和价值为price-wrap。 在此元素内,价格将位于具有属性的范围内itemprop有价值price。 为了找到它,我们使用 XPath 表达式'//span[@data-testid="price-wrap"]/span[@itemprop="price"]'. - 产品描述: 虽然本示例中未涵盖产品描述,但可以通过多种方式对其进行定位,具体取决于其在 HTML 结构中的位置。 您可以检查页面的源代码来识别适当的 HTML 元素和 XPath 来抓取描述。

- 顾客评论: 同样,可以使用 XPath 表达式来定位客户评论,该表达式针对包含评论数据的 HTML 元素,通常可以在标题为“客户评论”的部分下找到。

请注意: 上面引用的 HTML 元素是撰写此博客时的最新 HTML 元素。 请注意,这些元素将来可能会发生变化或更新。

了解这些关键元素及其各自的 XPath 表达式是网络抓取的基础。 通过分析沃尔玛产品页面的 HTML 结构,您将能够根据您的抓取需求提取特定的数据点。

在以下部分中,我们将演示如何使用 Selenium 和 Python 从沃尔玛产品页面中抓取产品名称和价格,同时考虑页面的结构和元素位置。

从沃尔玛页面 HTML 中抓取重要数据

让我们进入代码示例,演示如何从沃尔玛产品页面抓取产品名称和价格。 此代码示例说明了如何使用 Python 和 Selenium WebDriver 库从沃尔玛产品页面中抓取基本的产品详细信息。 该脚本的核心特征是 scrape_walmart_product_page 函数,它封装了此网络抓取任务的逻辑。

1 | 进口 os |

该脚本首先定义一个名为 scrape_walmart_product_page 的函数。 该函数采用 URL 作为输入,并使用 Selenium 与网页交互。 它会仔细等待特定元素(例如产品标题和价格)完全加载,然后提取并显示这一关键信息。 这种耐心的方法确保了数据检索过程的准确性和可靠性。

该脚本包含必要的配置以增强其多功能性。 它动态生成随机用户代理,模拟各种网络浏览器和操作系统。 这种动态的用户代理轮换有助于掩盖抓取活动,从而降低被目标网站检测到的风险。 此外,该脚本还优化了 Firefox 设置,使浏览器无头(没有可见界面)、配置窗口尺寸以及禁用 GPU 加速以提高性能。 它还演示了如何利用代理服务器,这在需要 IP 轮换或匿名的情况下是一个非常宝贵的功能。

为了增强脚本的稳健性,它包含一个内置的重试机制。 该机制允许用户指定最大重试次数和重试之间的暂停持续时间,从而优雅地处理超时或异常。

在主执行块中,脚本初始化关键组件,例如用户代理、Firefox 选项和代理设置。 它还指定要抓取的沃尔玛产品页面的 URL。 这 scrape_walmart_product_page 然后使用所选 URL 调用函数,启动抓取过程。

输出:

1 | 产品名称:Ozark Trail 基本网椅,蓝色,成人 |

通过研究和改编此示例,用户将获得对网络抓取技术的实用见解,同时确保其抓取工作的机密性。 该脚本的输出(包括产品标题和价格)可作为其成功执行的切实证据,展示其从沃尔玛等电子商务网站提取有价值数据的实用性。

5。 结论

在当代环境中,实时数据是众多企业和研究人员的命脉。 无论是跟踪市场趋势、监控竞争对手价格还是进行学术研究,访问沃尔玛等电子商务巨头的数据都可以提供宝贵的见解。 网络抓取是解锁这一信息宝库的关键,当与无头 Firefox Selenium 和 Crawlbase 智能代理结合使用时,它成为高效且有效的数据收集的有力工具。

这本综合指南将带您踏上网络抓取领域的旅程,特别关注使用 Python 和强大的自动化工具抓取沃尔玛产品页面的复杂性。 它为您提供了应对 IP 块、验证码和动态内容带来的挑战所需的知识和工具。 读完本指南后,您将能够利用无头 Firefox Selenium 的全部潜力和智能代理来抓取沃尔玛的大量产品列表。

无论您是经验丰富的数据科学家、业务分析师,还是渴望探索网络抓取世界的爱好者,本指南都为您提供了成功的路线图。 当您踏上数据驱动之旅时,您将获得从世界上最大的在线零售商之一提取、分析和利用数据的实践经验。

使用无头 Firefox Selenium 和智能代理进行网络抓取提供了一种强大的方法来访问和利用网络上可用的大量数据。 当您利用网络抓取来推动各自领域的见解和创新时,请记住负责任地使用这些新发现的知识,尊重网站政策和法律考虑。

6。 经常问的问题

问:使用带有智能代理的无头 Firefox Selenium 进行网页抓取有什么好处?

使用带有智能代理的无头 Firefox Selenium 为网络抓取提供了多种好处,包括能够绕过 IP 块和验证码、抓取更多页面而不被禁止、获得更准确和一致的结果以及更快地运行抓取操作并使用更少的资源。 这种组合提高了数据收集的效率和有效性,使其成为网络抓取专业人士的首选。

问:如何获取用于网页抓取的智能代理,它在该过程中的作用是什么?

您可以从 Crawlbase 等提供商处获取智能代理。 这些智能代理充当网络抓取应用程序和目标网站之间的中介,有效管理和轮换 IP 地址以绕过 IP 禁令和验证码。 它们在维护不间断的数据收集和确保抓取活动的匿名性方面发挥着至关重要的作用。

问:从沃尔玛产品页面抓取数据时需要考虑哪些关键要素?

从沃尔玛产品页面抓取数据时,必须了解页面的 HTML 结构,识别包含所需信息(例如产品标题和价格)的元素的唯一选择器,并使用 Selenium 和 XPath 表达式等工具来定位和提取数据。 此外,请考虑 HTML 结构可能会随着时间的推移而发生变化,因此可能需要定期调整您的抓取代码。