如今,从市场研究到学术研究,访问和分析网络数据已成为许多任务不可或缺的一部分。 HTML 表格是网站组织和呈现数据的常用方式,使其成为数据提取的宝贵资源。无论您是研究人员、分析师还是爱好者,了解如何从网站上抓取表格都可以让您触手可及的信息世界。

本博客将指导您通过三种不同的方法从网站上抓取表格,以满足不同的偏好和技能水平。我们将探索使用 Google Sheets、带有 rvest 包的 R 语言和 Python,每种语言都有自己的优势和功能。最后,您将拥有从网络高效地提取有价值的数据表的工具和知识。

现在,让我们深入了解 HTML 表格的复杂性以及为什么它们对于网页抓取至关重要。

目录

- 什么是 HTML 表格以及它们为何如此重要?

- 如何使用 Google Sheets 提取 HTML 表格数据

- 使用 R 的 rvest 包提取网站表数据

- 如何从 Python 网站抓取表格

- 最后的思考

- 常见问题解答(FAQ)

什么是 HTML 表格以及它们为何如此重要?

HTML 表格是网页上使用的结构化元素,用于以表格格式组织和显示数据。它们由行和列组成,每个单元格包含与其相应的行和列交叉点相关的信息。这些表格在网站上呈现数据方面发挥着至关重要的作用,使用户更容易理解和分析信息。

如何使用 Google Sheets 提取 HTML 表格数据

使用 Google Sheets 提取表格数据是一种方便且直接的方法,使您可以从网站收集信息,而无需复杂的编码或软件。您可以这样做:

- 打开 Google 表格:首先打开新的或现有的 Google 表格文档。

- 访问 ImportHTML 功能:Google 表格提供了一个名为 ImportHTML 的内置功能,可让您从网络上的 HTML 页面导入表格和列表。要访问此功能,请单击要在其中显示导入数据的单元格。

- 输入功能:在选定的单元格中,键入“=IMPORTHTML(“,后跟包含要提取的表格的网页的 URL。然后,指定是要导入表格还是列表,以及表格的索引号(如果页面上有多个表格)例如。

=IMPORTHTML("https://en.wikipedia.org/wiki/Wonders_of_the_World","table",1)

- 按Enter键:输入函数后按回车键,Google Sheets 会自动从指定的 URL 导入表格数据并显示在选定的单元格中。

- 调整格式:导入数据后,您可能需要调整格式,例如调整列大小或格式化单元格,以使信息更具可读性和组织性。

- 刷新数据(可选):Google Sheets 允许您将导入的数据设置为定期自动刷新。这可确保您的电子表格始终反映网页中的最新信息。

通过执行以下步骤,您可以使用 Google 表格轻松从网站中提取表格数据。此方法对于喜欢用户友好界面且不具备高级编码技能的用户特别有用。此外,Google Sheets 还提供协作功能,允许多个用户同时处理同一个电子表格,使其成为团队项目和数据分析任务的便捷选择。

使用 R 的 rvest 包提取网站表数据

使用 R 语言和 rvest 包提供了一种从网站抓取表格的强大方法。以下是如何从网站 r 中抓取表格的方法。

- 安装 rvest 包:如果您尚未安装 rvest 软件包,可以通过在 R 控制台中运行以下命令来安装:

1 | 安装包(“RVEST”) |

- 加载 rvest 包:安装后,您需要使用以下命令将 rvest 包加载到 R 环境中:

1 | 图书馆(投资){% asset_img "why-scrape-html-tables.jpg" "为什么要抓取 HTML 表格 '为什么要抓取 HTML 表格'" %} |

指定网址:接下来,指定包含要抓取的表的网页的 URL。

使用 html_table 函数:rvest 包中的 html_table 函数允许您从 HTML 页面中提取表格。将此功能与

read_html函数读取网页的HTML内容并将其转换为包含表格数据的数据框。

1 | # 将 'url' 替换为包含该表的网页的 URL |

访问表数据:提取表数据后,您可以像 R 中的任何其他数据帧一样访问它。使用索引或列名称来访问表的特定行或列。

可选:数据清理:根据表的结构和您的具体要求,您可能需要执行一些数据清理或操作以准备用于分析的数据。这可能包括删除不需要的行或列、转换数据类型或处理缺失值。

通过执行以下步骤,您可以使用 R 语言和 rvest 包轻松地从网站上抓取表格。此方法对于喜欢使用 R 编程语言并希望自动化从网站提取数据以进行分析和可视化的过程的 R 用户特别有用。

完整的工作示例:

1 | # 安装并加载rvest包 |

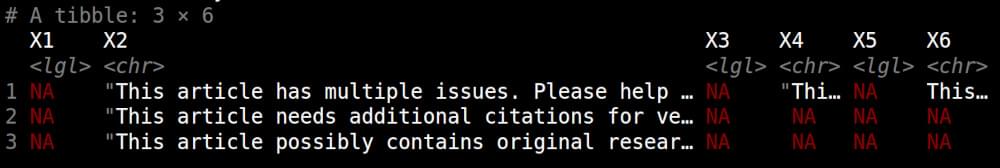

示例输出:

如何从 Python 网站抓取表格

Python 是一种功能强大的编程语言,拥有 Requests、BeautifulSoup 和 Pandas 等库,使网络抓取任务相对简单。按照以下步骤从 Python 网站上抓取表格。

- 安装必要的库:首先,确保您安装了 requests 和 BeautifulSoup 库。如果没有,您可以使用 pip 安装它们:

1 | pip install 请求 beautifulsoup4 pandas |

- 导入库

在您的 Python 脚本中,导入所需的库:

1 | 止 bs4 进口 美丽汤 |

- 获取网页:使用 requests 库向包含要抓取的表的网页的 URL 发送 GET 请求。这将检索网页的 HTML 内容。

1 | 网址= “https://www.example.com/table-page” |

- 解析 HTML 内容:接下来,使用BeautifulSoup解析网页的HTML内容并导航到您要抓取的表格。您可以使用 BeautifulSoup 的 find 或 find_all 方法根据 HTML 结构来定位表。

1 | 汤 = BeautifulSoup(html_content, “html.解析器”) |

- 提取表数据:迭代表并将其转换为 Pandas DataFrame 以便于操作:

1 | 表数据 = [] |

- 保存或操作数据

您现在可以将抓取的表数据保存到 CSV 文件,或使用 Pandas 执行进一步分析和 manipulatSave 或 Manipulate Dataion:

1 | idx, df in 枚举(表数据): |

- 可选:数据清理:根据您的要求,您可能需要对提取的数据执行一些数据清理或操作。这可能包括删除不需要的行或列、转换数据类型或处理缺失值。

通过执行以下步骤,您可以使用 Python 从网站中抓取表格。这种方法用途广泛,可用于从各种带有表格的网站中提取数据,使其成为数据收集和分析任务的宝贵工具。

完整的工作示例:

1 | 止 bs4 进口 美丽汤 |

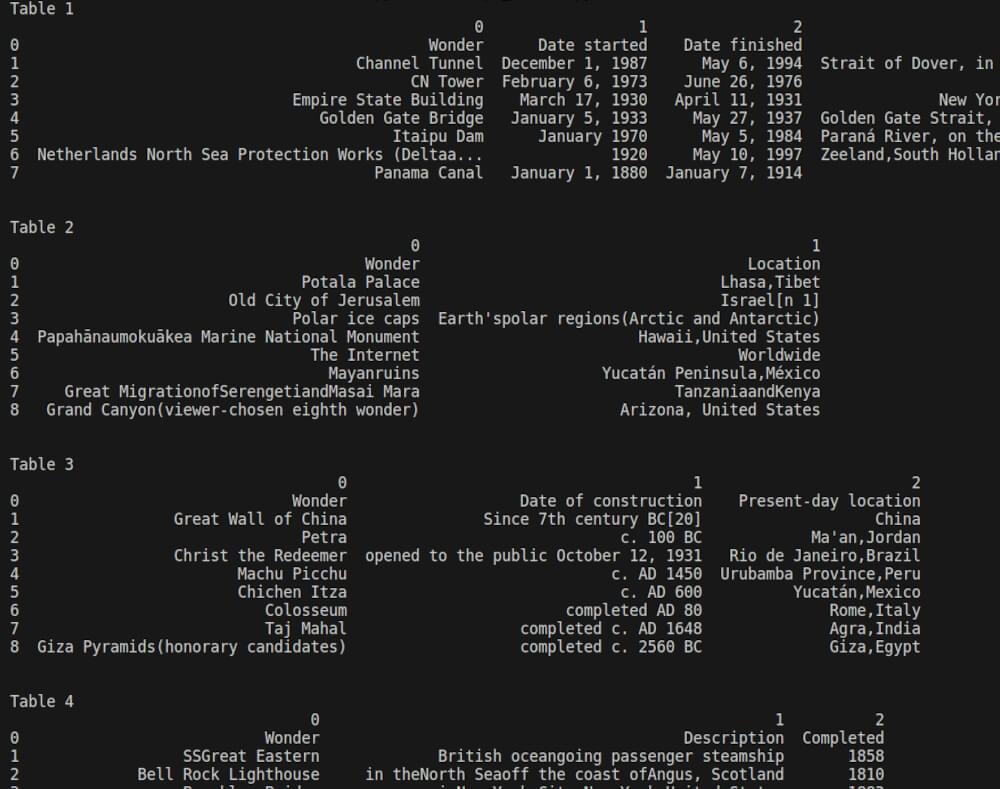

示例输出:

最后的思考

从网站上抓取表格是有效提取和分析数据的一项宝贵技能。无论您使用 Google Sheets、带有 rvest 包的 R 语言,还是 BeautifulSoup 和 Pandas 等 Python 库,该过程都允许您从各种在线资源收集见解。通过了解 HTML 结构并利用正确的工具,您可以自动执行数据提取任务并简化工作流程。

如果您有兴趣了解有关网络抓取的更多信息,请阅读我们的以下指南。

📜 网页抓取维基百科

📜 如何抓取谷歌学术搜索结果

📜 如何抓取 Quora

📜 如何使用 Chatgpt 抓取网站

📜 剧作家网络抓取

📜 如何抓取 TikTok 评论

不断探索不同的抓取方法并随时了解最佳实践,以便在您的项目中充分利用网络抓取。如果您有任何问题或反馈,我们的 支持团队 随时为您的网络抓取之旅提供帮助。快乐刮擦!

常见问题解答(FAQ)

问:从网站上抓取表格以提取数据是否合法?

虽然网络抓取本身并不违法,但负责任地抓取并遵守网站的服务条款和版权法至关重要。避免未经许可抓取敏感或受版权保护的数据,并避免因过多的请求而使网站服务器超载。请务必检查网站的 robots.txt 文件是否有抓取权限,并在必要时考虑获得同意。

问:从网站抓取表格的常见挑战是什么?

从网站上抓取表格可能会遇到一些挑战,例如 HTML 结构不一致、通过 JavaScript 动态加载内容以及验证码和 IP 阻止等反抓取措施。然而,借助正确的工具和技术,可以通过了解网站的结构并使用浏览器自动化和代理轮换等方法来克服这些挑战。

问:如何在抓取 HTML 表格时解锁网站?

由于 IP 阻止或验证码等安全措施,在 HTML 表格抓取期间解除阻止网站可能具有挑战性。一种有效的解决方案是使用 Crawlbase 的 抓取 API。 Crawlbase 提供了一个可靠的解决方案来绕过阻止并无缝访问网站内容。凭借其轮换代理和用户代理字符串,Crawlbase 确保顺利进行抓取操作,同时尊重网站服务条款。通过将 Crawlbase 的 API 集成到您的抓取脚本中,您可以克服阻塞措施并有效地提取 HTML 表数据。

问:从网站抓取表格时如何处理动态内容?

动态内容(例如通过 JavaScript 或 AJAX 调用加载的数据)可能会给传统的 Web 抓取技术带来挑战。为了有效地处理动态内容,请考虑使用无头浏览器,例如 Selenium WebDriver,它可以像真正的浏览器一样执行 JavaScript 并呈现网页。您还可以使用第三方 API,例如 Crawlbase 的 抓取 API 处理动态内容。

或者,分析网页发出的网络请求,以识别负责动态获取数据并直接从这些端点抓取数据的 API 端点。