使用最好的网络爬虫 对于 Reddit

使用我们的抓取工具从 Reddit 访问各种数据。

以无限带宽抓取任何网页

易于设置、对初学者友好的 API

针对可靠性和速度进行了优化

注册后 1000 个免费请求

创建一个免费帐户,然后从仪表板申请。

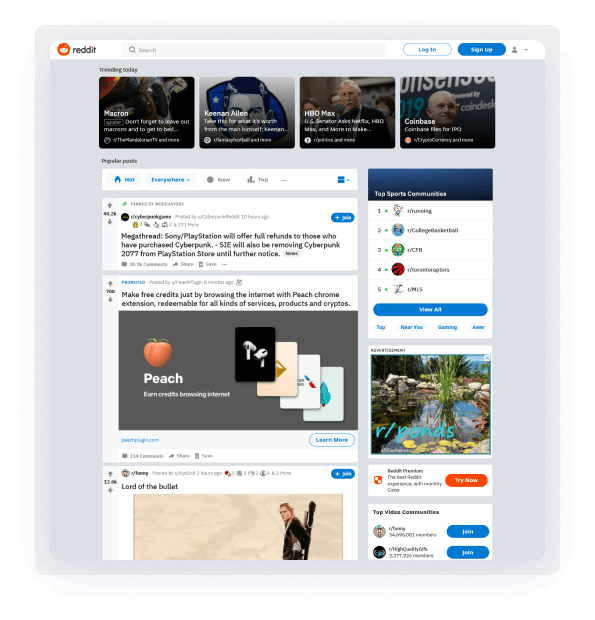

Reddit 是世界上最大的网站之一。 这个社交平台于 15 年前推出,并且比以往任何时候都更受欢迎。 截至 2020 年,全球每月活跃用户超过 430 亿。 了解数据价值的人都知道,它是一座名副其实的金矿。

抓取 Reddit 帖子、页面和 subreddit

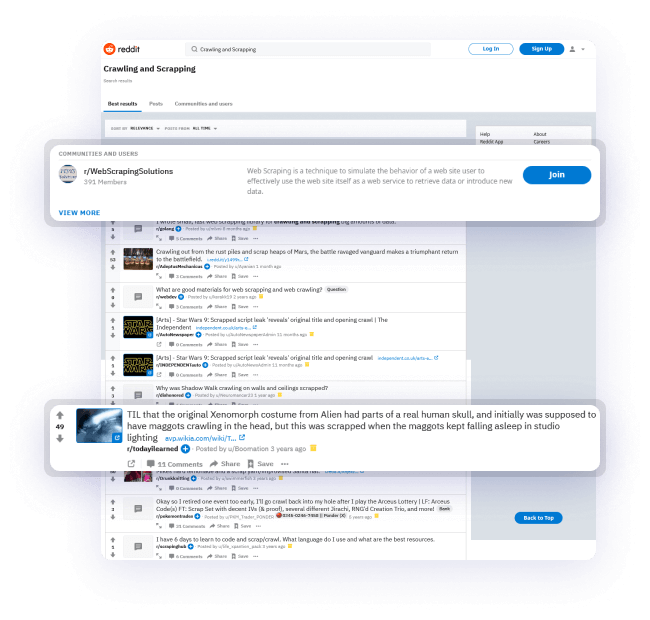

如果您打算抓取 Reddit,您应该知道这是一项艰巨的任务并且成本很高,尤其是抓取大量帖子和搜索结果。 在大多数情况下,您会发现您的抓取工具被阻止,并且需要不断更改算法,这反过来会导致您花费不必要的时间和精力。

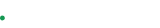

使用 Crawlbase 可以帮助您轻松获取所需的信息。 快速可靠地抓取 Reddit 帖子和子版块,停机时间几乎为零。

安全地抓取数百万个 Reddit 搜索结果

我们的 API 建立在全球数千个住宅和数据中心代理之上,并结合人工智能,因此您可以匿名抓取 Reddit 页面、帖子和 subreddit。 Crawlbase 可以毫不费力地避免 CAPTCHA 并且对被阻塞的请求提供最好的保护。

为您的项目获取数据,而无需担心设置代理或基础架构。 我们会为您解决这个问题,保证提供尽可能最好的数据结果。

每个人都易于使用的 API

适用于初学者和专家,适用于小型和大型项目,适用于用户和开发人员。 我们的 API 非常易于使用,您可以在几分钟内开始抓取 Reddit。

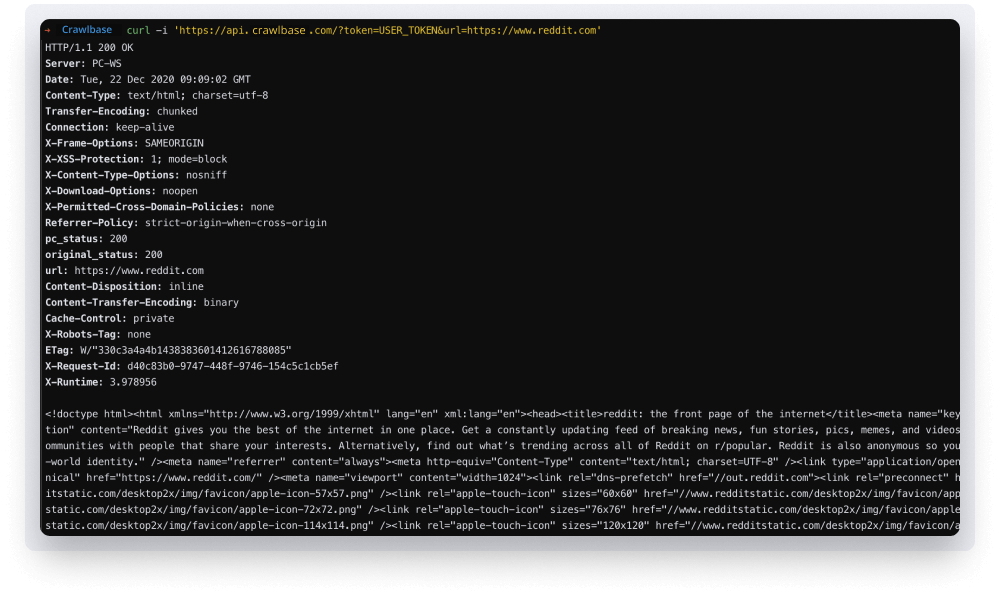

立即注册并使用一个简单的 cURL 请求尝试您的第一个 API 调用来获取您的令牌:

该产品的灵活性使公司能够以最小的努力将 API 集成到现有的基础设施上。 如果您的企业需要来自 Reddit 的新数据,那么您来对地方了。

今天开始爬网

免费尝试。 无需信用卡。 即时设置。