欢迎阅读我们有关使用 Python 抓取 GitHub 存储库和用户配置文件的指南。

无论您是数据爱好者、研究人员还是希望从 GitHub 获得见解的开发人员,本指南都将为您提供导航 GitHub 庞大的存储库和用户环境所需的知识和工具。

让我们开始吧!

如果您想直接设置 python,请单击 此处.

目录

- 安装Python

- 设置虚拟环境

- 安装所需的Python包

- GitHub 存储库

- GitHub 用户个人资料

- 导航 GitHub 存储库

- 提取相关信息

- 实施抓取过程并保存到 CSV

- 浏览用户配置文件

- 检索用户详细信息

- 实施抓取过程并保存到 CSV

为什么要抓取 GitHub 存储库和配置文件

GitHub Scraping 涉及系统地从 GitHub平台,一个软件开发的中心枢纽,包含源代码、提交历史记录、问题和讨论等信息数据。

GitHub 以其庞大的用户群和大量的用户而享有盛誉。 因此,它是开发人员抓取的首选。 GitHub 抓取或从 GitHub 存储库和用户配置文件收集数据对于各种个人和目的都很重要。 下面列出了其中一些:

项目评估:

- 了解项目受欢迎程度:通过抓取存储库,用户可以根据星星、分叉和观察者等指标来衡量项目的受欢迎程度。 此信息对于项目经理和开发人员评估项目的影响和用户参与度非常有价值。

- 分析贡献者活动:抓取允许提取与贡献者、他们的贡献和提交频率相关的数据。 此分析有助于了解项目内的活动水平,帮助识别关键贡献者并评估项目的整体健康状况。

趋势分析:

- 识别新兴技术:GitHub 是创新中心,抓取可以识别新兴技术和编程语言。 这种见解对于开发人员和组织了解行业趋势并就技术采用做出明智的决策非常有价值。

- 跟踪流行框架:用户可以通过分析存储库来识别流行的框架和库。 这些信息对于开发人员选择项目工具至关重要,确保它们符合行业趋势和社区偏好。

社交网络洞察:

- 揭示协作网络:抓取 GitHub 个人资料可以揭示用户联系,展示协作网络和关系。 了解这些社交方面可以深入了解有影响力的贡献者、社区动态以及 GitHub 生态系统的相互关联性质。

- 发现趋势存储库:用户可以通过抓取用户个人资料来识别趋势存储库。 这有助于发现在社区中获得关注的项目,使开发人员能够探索最新、最相关的举措并为其做出贡献。

数据驱动决策:

- 明智的决策:GitHub 抓取使个人和组织能够做出数据驱动的决策。 无论是评估项目可行性、选择技术还是识别潜在合作者,从 GitHub 存储库和配置文件中提取的数据都可以作为决策过程的宝贵基础。

设置环境

我们需要首先设置并安装 Python 及其必要的包。 那么让我们开始吧。

安装Python

如果您尚未安装 Python,请前往 Python官方网站 并下载适合您操作系统的最新版本。 请按照网站上提供的安装说明进行操作,以确保安装顺利。

要检查 Python 是否已安装,请打开命令提示符或终端并键入:

1 | python --version |

如果安装正确,此命令应显示已安装的 Python 版本。

设置虚拟环境

为了为我们的项目维护一个干净且隔离的工作空间,建议使用虚拟环境。 虚拟环境可以防止不同项目依赖关系之间的冲突。 请按照以下步骤设置虚拟环境:

**对于 Windows:

**

- 打开命令提示符。

- 使用 cd 命令导航到您的项目目录。

- 创建虚拟环境:

1 | python -m venv venv |

- 激活虚拟环境:

1 | 资源 venv/bin/激活 |

您应该在命令提示符或终端中看到虚拟环境的名称,表明它处于活动状态。

安装所需的Python包

激活虚拟环境后,您现在可以为我们的 GitHub 抓取项目安装必要的 Python 包。 创建一个 requirements.txt 文件放在项目目录中并添加以下内容:

1 | 爬行基地 |

使用以下命令安装软件包:

1 | pip install -r requirements.txt |

爬虫库:这个库是我们网络抓取过程的核心。 它使我们能够 HTTP请求 使用 Crawlbase 抓取 API 访问 Airbnb 的属性页面。

美汤4:Beautiful Soup 是一个 Python 库,可以简化网页 HTML 内容的解析。 它是提取数据不可或缺的工具。

熊猫:Pandas 是 Python 中一个强大的数据操作和分析库。 我们将使用它来有效地存储和管理抓取的价格数据。

您的环境现已设置完毕,您已准备好继续我们的 GitHub 抓取之旅的后续步骤。 在接下来的部分中,我们将探索 GitHub 的数据结构,并向您介绍 Crawlbase 爬行 API,以获得无缝的抓取体验。

了解 GitHub 的数据结构

本节将剖析两个基本实体:GitHub 存储库和 GitHub 用户配置文件。 此外,我们将确定对于提取有价值的见解具有重要意义的特定数据点。

GitHub 存储库:

存储库名称和描述

存储库名称及其随附的描述可以让您简要了解项目的目的和目标。 这些元素提供上下文,有助于对存储库进行分类和理解。

星星、分叉和观察者

诸如星星、分叉和观察者之类的指标是存储库受欢迎程度和社区参与度的指标。 “星星”反映用户认可,“分叉”表示项目贡献或衍生,“观察者”代表有兴趣跟踪更新的用户。

合作者

识别贡献者可以深入了解项目的协作性质。 提取积极参与存储库的个人列表对于了解其开发动态非常有价值。

Topics

存储库通常标有主题,作为描述性标签。 提取这些标签可以进行分类,并有助于根据常见主题对存储库进行分组。

GitHub 用户个人资料

用户简介和位置

用户的个人简介和位置提供了其背景的简要概述。 在分析 GitHub 贡献者的人口统计数据和兴趣时,此信息可能特别相关。

库

与用户关联的存储库列表提供了他们的贡献和创建的快照。 这些数据对于了解用户的专业知识和感兴趣的领域至关重要。

活动概览

跟踪用户最近的活动,包括提交、拉取请求和其他贡献,可以实时查看他们对 GitHub 社区的参与情况。

关注者和关注者

检查用户的关注者及其关注的帐户有助于绘制用户在 GitHub 内的网络。 这个社会方面对于识别有影响力的人物和社区联系很有洞察力。

Crawlbase:注册、获取API Token

要释放 Crawlbase 爬网 API 的潜力,您需要注册并获取 API 令牌。 请按照以下步骤开始:

- 访问 Crawlbase 网站:导航至 Crawlbase 网站 登录 选项。

- 创建一个帐户:通过提供必要的详细信息注册 Crawlbase 帐户。

- 验证您的电子邮件:验证您的电子邮件地址以激活您的 Crawlbase 帐户。

- 访问您的仪表板:登录您的 Crawlbase 帐户并访问用户仪表板。

- 访问您的 API 令牌:您需要 API 令牌才能使用 Crawlbase 爬网 API。 您可以在 Crawlbase 仪表板上找到您的 API 令牌,或者 此处.

备注:Crawlbase 提供两种类型的令牌,一种用于静态网站,另一种用于动态或 JavaScript 驱动的网站。 由于我们正在抓取 GitHub,因此我们将选择普通令牌。 Crawlbase 慷慨地为 Crawling API 提供 1,000 个免费请求的初始限额,使其成为我们网络抓取项目的绝佳选择。

确保您的 API 令牌安全,因为它将有助于验证您对 Crawlbase API 的请求。

探索爬取API文档

熟悉 Crawlbase 爬取API文档 对于有效利用其能力至关重要。 该文档作为综合指南,提供对可用端点、请求参数和响应格式的深入了解。

- 端点信息:了解 API 提供的不同端点。 这些功能可能包括浏览网站、处理身份验证和检索数据等功能。

- 请求参数: 抓住 参数 可以包含在您的 API 请求中。 这些参数允许您定制请求以提取特定的数据点。

- 响应格式: 探索结构 API 响应。 文档的这一部分概述了数据的呈现方式,使您能够在 Python 脚本中有效地解析和利用它。

抓取 GitHub 存储库

当冒险进入抓取 GitHub 存储库的领域时,利用 Crawlbase 抓取 API 的功能可以提高效率和可靠性。 在本详细指南中,我们将探讨导航 GitHub 存储库、提取有价值的详细信息以及最重要的将数据保存到 CSV 文件中的复杂性。 仔细遵循每个步骤,在每个阶段维护一个脚本,以便清晰且易于修改。

导航 GitHub 存储库

首先导入必要的库并使用您的唯一令牌初始化 Crawlbase API。

1 | 进口 大熊猫 as pd |

提取相关信息

专注于 scrape_page 函数,负责实际的抓取过程。 该函数将 GitHub 存储库 URL 作为输入,利用 Crawlbase API 发出 GET 请求,并利用 BeautifulSoup 从 HTML 中抓取相关信息。

1 | DEF 刮页(页面地址): |

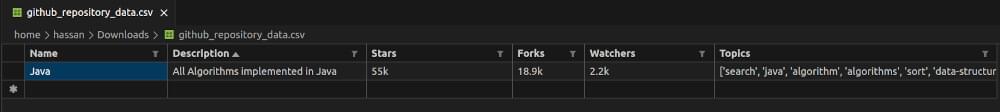

实施抓取过程并保存到 CSV

在 main 函数,指定要抓取的 GitHub 存储库 URL 并调用 scrape_page 函数来检索相关信息。 此外,将提取的数据保存到 CSV 文件中以供将来分析。

1 | DEF 主(): |

通过执行这些步骤,您不仅可以无缝导航 GitHub 存储库,还可以提取有意义的见解并将数据保存到 CSV 文件中以供进一步分析。 这种模块化和系统化的方法提高了抓取过程的清晰度,并有助于轻松修改脚本以满足您的特定要求。 根据您的需求自定义代码,并自信地解锁 GitHub 上提供的大量数据。

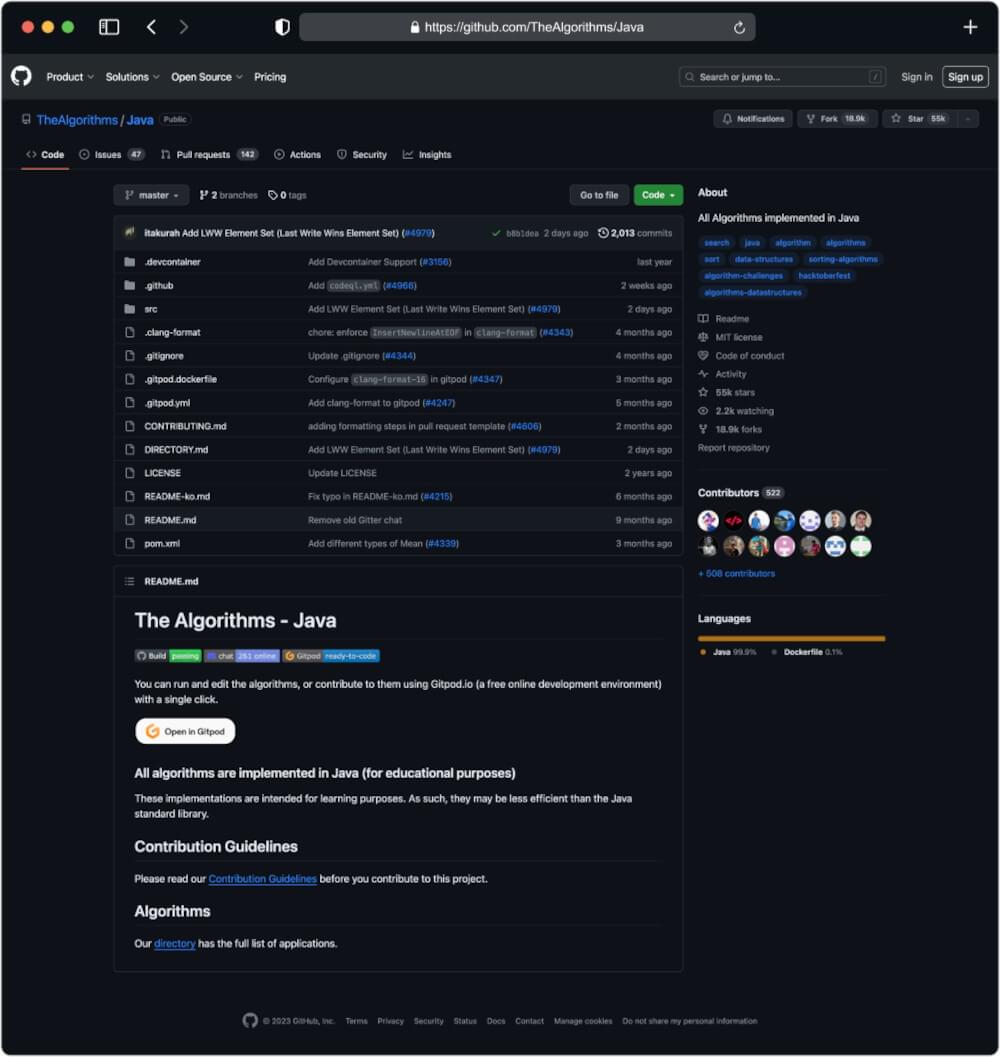

URL 的输出: https://github.com/TheAlgorithms/Java

抓取 GitHub 用户配置文件

当将 GitHub 抓取工作扩展到用户配置文件时,Crawlbase 抓取 API 的效率仍然非常宝贵。 本节概述了浏览 GitHub 用户配置文件、检索基本详细信息和实施抓取过程所涉及的步骤。 此外,我们还将介绍如何将提取的数据保存到 CSV 文件中以供进一步分析。 与往常一样,在每个步骤维护脚本可确保清晰度并方便修改。

浏览用户配置文件

首先导入必要的库,使用您的唯一令牌初始化 Crawlbase API。

1 | 进口 大熊猫 as pd |

检索用户详细信息

定义 scrape_user_profile 函数,负责向 GitHub 用户个人资料发出 GET 请求并提取相关信息。

1 | DEF scrap_user_profile(个人资料网址): |

实施抓取过程并保存到 CSV

在 main 函数,指定要抓取的 GitHub 用户配置文件 URL,调用 scrape_user_profile 函数检索相关信息,并将数据保存到 CSV 文件中 pandas.

1 | DEF 主(): |

通过执行这些步骤,您将能够无缝导航 GitHub 用户配置文件、检索有价值的详细信息并将提取的数据保存到 CSV 文件中。 根据您的具体要求调整代码,并充满信心地探索 GitHub 用户配置文件上提供的丰富信息。

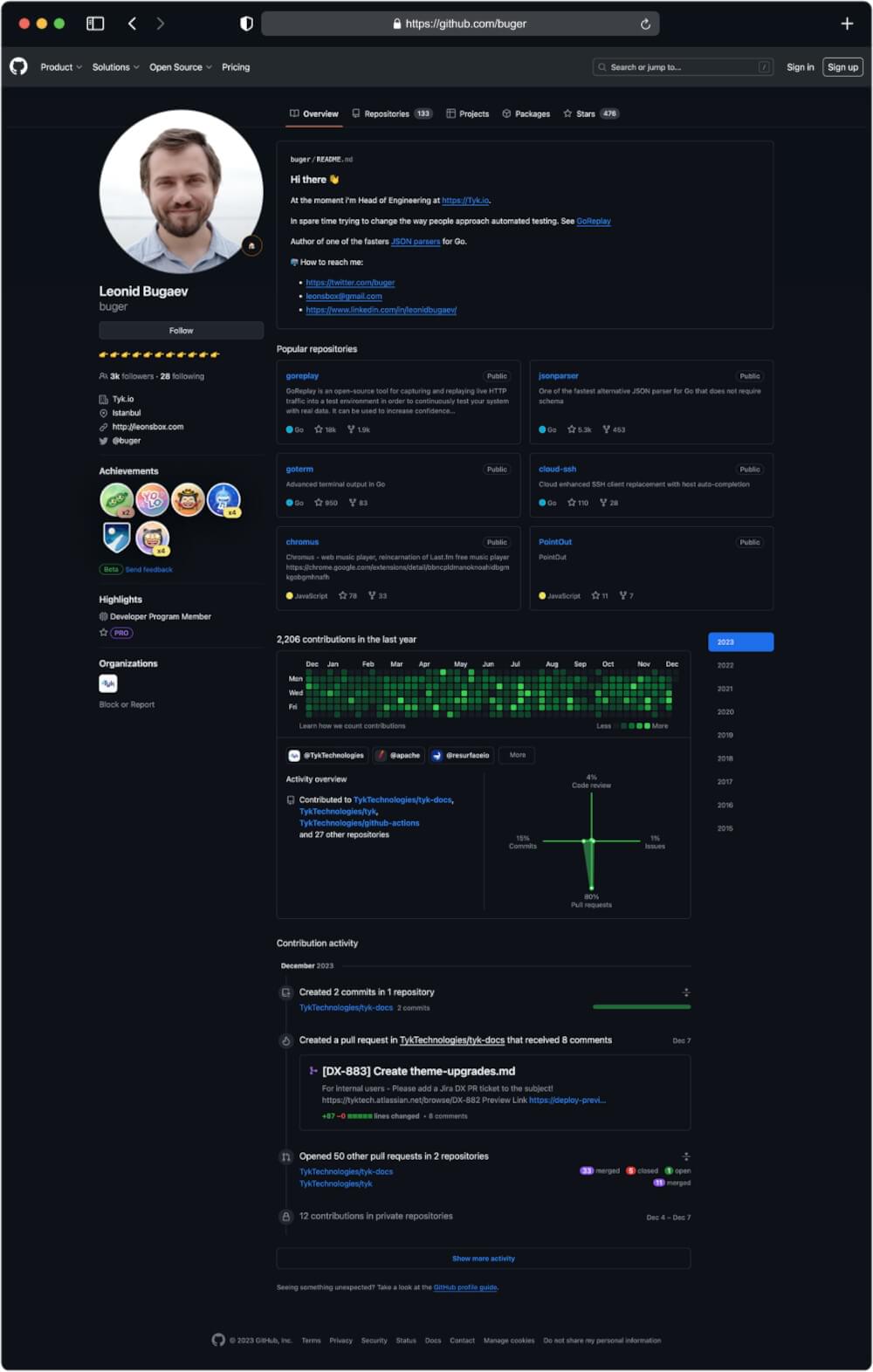

URL 的输出: https://github.com/buger

总结

恭喜! 您直接从网页获取原始数据,并将其转换为 JSON 文件中的结构化数据。 现在您已经了解了如何使用 Python 构建 GitHub 存储库抓取工具的每一步!

本指南为您提供了使用 Python 和 Crawlbase 爬行 API 轻松抓取 GitHub 存储库和配置文件的基本知识和工具。 继续阅读我们的博客以获取更多此类教程。

在此之前,如果您遇到任何问题,请随时联系 Crawlbase支持团队。 您在网络抓取方面的成功是我们的首要任务,我们期待在您的抓取之旅中为您提供支持。

常见问题解答

问:为什么 GitHub 抓取很重要?

出于多种原因,GitHub 抓取至关重要。 它允许用户分析趋势、跟踪项目受欢迎程度、识别贡献者并深入了解软件开发不断发展的格局。 研究人员、开发人员和数据爱好者可以利用抓取的数据做出明智的决策并了解最新的行业发展。

问:网络抓取 GitHub 合法吗?

虽然 GitHub 允许公众访问某些数据,但必须遵守 GitHub 的服务条款。 出于个人或教育目的而抓取公共数据通常是可以接受的,但尊重网站的条款和条件至关重要。 避免未经授权抓取私人数据,并确保遵守相关法律和政策。

问:Crawlbase Crawling API 如何增强 GitHub 抓取?

Crawlbase 抓取 API 通过提供无缝网站导航、身份验证管理、速率限制处理和 IP 轮换等功能来简化 GitHub 抓取,以增强数据隐私。 它简化了抓取过程,使其更加高效,并允许用户专注于提取有意义的数据。

问:GitHub 抓取中的道德考虑因素有哪些?

尊重 GitHub 的服务条款至关重要。 用户应该在其抓取脚本中实施速率限制,以避免压垮 GitHub 的服务器。 此外,区分公共数据和私有数据至关重要,确保只有在经过适当授权的情况下才能访问私有存储库和敏感信息。

问:是否可以在不使用 Crawlbase 爬行 API 并仅依赖 Python 的情况下抓取 GitHub 存储库和配置文件?

是的,可以单独使用 Python 以及 requests 和 BeautifulSoup 等库来抓取 GitHub。 然而,重要的是要注意 GitHub 施加了速率限制,过多的请求可能会导致 IP 阻塞。 为了减轻这种风险并确保更可持续的抓取体验,建议利用 Crawlbase 抓取 API。 该 API 简化了抓取过程,并结合了智能速率限制处理和轮换 IP 地址等功能,使用户能够浏览 GitHub 的复杂性,而不会面临被阻止的风险。 这确保了更可靠、更高效的抓取工作流程。