因此,您有一家企业,想要抓取 LinkedIn 来为您的营销团队收集数据。 您想要抓取数百个公司页面甚至用户个人资料来实现您的目标。 您会手动执行此操作并花费宝贵的时间、时间和资源吗? 好吧,在 Crawlbase 中,我们说您不必这样做。 我们的 抓取 API 内置 LinkedIn 数据抓取器 可以帮助您更快地实现目标并取得卓越的成果。

在本指南中,我们将共同构建一个简单的 Ruby 抓取工具,用于抓取 Amazon 的 LinkedIn 公司资料,然后将其应用于您选择的任何公司。

设置刮刀

要真正开始用 Ruby 编写代码,我们需要准备以下内容:

- API 网址

https://api.crawlbase.com - Scraper 参数 ( scraper = linkedin-company )

- 您的 Crawlbase 令牌

- 领英公司网址

使用 Crawlbase 抓取 LinkedIn

现在,让我们创建一个文件并将其命名为 linkedin.rb,其中将包含我们的 ruby 代码。

要开始编码,请打开您创建的文件,然后我们将首先初始化库并创建一个模块来处理我们的 API、令牌和 URL。 不要忘记也插入刮板linkedin-company。

您可以将您的普通令牌用于 LinkedIn,并确保将其替换为实际的令牌 您可以在您的帐户中找到.

1 | 要求 '网络/http' |

现在我们已经完成了第一部分,让我们编写其余的代码。 对于这一部分,我们将获取 URI 模块的响应,HTTP 状态代码,并使用函数 JSON.pretty_generate 以便我们的代码将返回一个更具可读性的 JSON 正文。

完整的代码现在应该如下所示:

1 | 要求 '网络/http' |

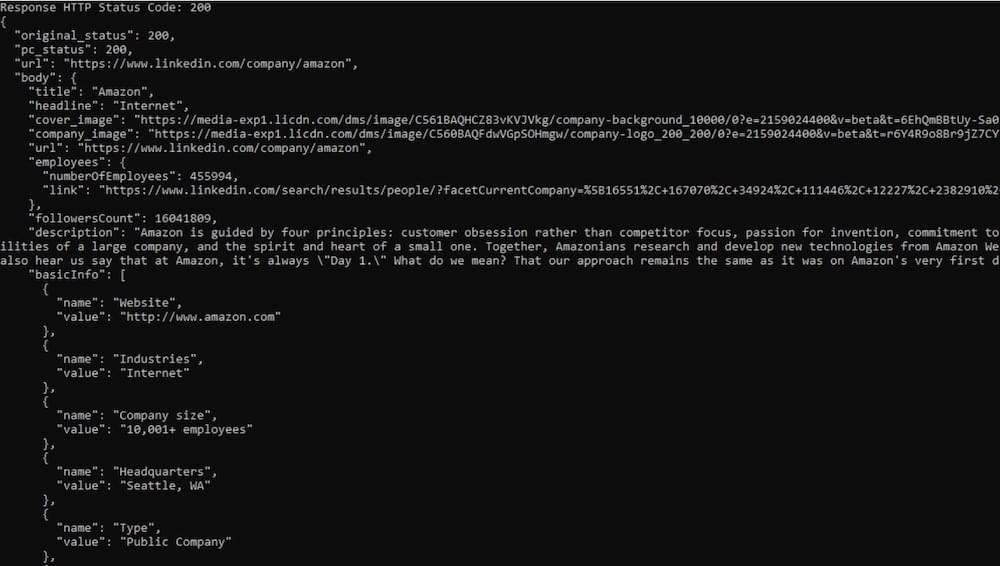

现在我们只需要保存我们的工作并运行代码。 结果将返回以下解析数据:

(示例输出)

我们都准备好了! 现在轮到您随意使用此代码了。 请务必替换您要抓取的 LinkedIn URL。 或者,您可以自由使用我们的 爬行红宝石库. 另外,请记住,我们有两个用于 LinkedIn 的爬虫,即 linkedin资料 和 领英公司 这是不言自明的。

您将如何以及在何处使用您提取的信息? 全取决于你。

我们希望你喜欢这个教程,我们希望很快见到你 爬虫库. 快乐爬行!

选择 Crawlbase 的 5 个理由?

当访问网站获取数据时, 爬虫库 往往是最好的选择。 原因如下:

- 无限制访问: 爬行 API 提供对几乎所有网站的无限制访问。 您可以轻松更改您的 IP 地址、cookie 和其他浏览器数据,从而更轻松地收集您需要的信息。

- 保持匿名: 通过 Crawling API,您的匿名性得以保留。 您可以更改您的 IP 地址并清除 cookie,确保您的在线活动保持私密性。

- 自动化安全: 抓取 API 附带自动化安全措施,包括轮换 IP 和 cookie 管理等功能。 这种内置的安全性增强了您的网络抓取体验,同时保证了您的数据安全。

- 更快的抓取: 凭借自动化的安全性和不受限制的访问,Crawling API 可提供更高的抓取速度。 这意味着您可以更快、更高效地收集数据。

- 增强的安全性: 同样,自动化安全措施和 IP 轮换使您的在线活动更加安全。 您的匿名性受到保护,并且您的数据不会受到潜在威胁。

Crawling API 是网络抓取的可靠且安全的选择,为您提供访问网站、收集数据和保护您的在线隐私所需的工具和功能。

让我们澄清一下 LinkedIn 上 Ruby 网页抓取的法律问题

您可能想知道从 LinkedIn 抓取数据是否合法。 关于这个问题有很多意见。 让我们以最真实、最简单的方式来解决这个问题。

LinkedIn 是专业人士联系和分享信息的平台。 它包含大量数据,某些人或企业可能希望出于各种目的收集这些数据。 然而,LinkedIn 制定了具体规则来保护其用户的公开和隐藏数据。

LinkedIn 的规则禁止使用抓取、爬行或数据挖掘等自动化方法从其平台收集数据。 为了执行这些规则,LinkedIn 采用了技术保障措施,例如速率限制、验证码和 IP 阻止。 这些措施旨在确保只有授权用户才能访问平台及其数据。

当涉及公共领域数据时,情况有些不同。 只要您收集的是可公开访问的数据,LinkedIn 的政策不会使抓取 LinkedIn 变得不道德、非法或不安全。 欧盟和美国法律都不禁止抓取公共领域数据,即使公司的政策反对。

值得注意的是,虽然美国最高法院已经裁定禁止在在线数据库中搜索信息的法律无效,但它并没有直接解决抓取问题。 这意味着访问 LinkedIn 并收集有关某人的公开信息通常是合法的。 然而,始终保持在法律范围内至关重要。

为了安全起见,请确保您仅收集可公开访问的数据并遵守 LinkedIn 的法律界限。

您可以从 LinkedIn 抓取哪些类型的数据?

LinkedIn 提供了大量数据,您可以出于各种目的抓取这些数据。 以下是您可以使用 Ruby LinkedIn scraper 收集的一些主要数据点:

- 领英个人资料: 这包括 LinkedIn 用户的个人资料,其中通常包含有价值的专业信息。

- 领英群组: 可以抓取有关 LinkedIn 群组的信息,帮助您深入了解不同的社区。

- 领英公司简介: 使用 Ruby scraper,您可以从 LinkedIn 上的公司资料中提取数据,这对于业务相关目的非常有用。

- 职位列表: Ruby LinkedIn 抓取工具可以提取工作列表,以提供有关可用工作机会和提供这些工作机会的公司的信息。

- 搜索结果: LinkedIn 搜索结果中的数据可以帮助您找到与您的搜索查询相关的特定个人资料或信息。

然而,您可以使用 Ruby scraper 收集的数据范围超出了这些类别。 为了加强您的外展工作,请考虑收集其他数据点,例如:

- 全名和职务: 了解一个人的姓名和职位对于个性化外展至关重要。

- 教育背景、地点和联系方式: 收集有关某人的教育程度、位置和联系方式的信息(包括工作和个人电子邮件地址以及手机号码)可以帮助您建立直接沟通。

- 公司信息: 收集有关潜在客户公司的数据,例如公司名称、域名、规模、行业、地点和成立年份,可以帮助您设计战略方法。

- 社交媒体简介: 在 LinkedIn、Facebook、Twitter 和 GitHub 等平台上查找潜在客户其他社交媒体资料的链接。

- 连接计数和 Sales Navigator URL: 这些详细信息提供了对目标网络的深入了解,对于销售和外展工作非常有价值。

通过使用 Ruby LinkedIn 抓取工具收集如此广泛的数据点,您可以使您的外展工作具有高度针对性和有效性。

使用 Ruby 进行 LinkedIn 网页抓取的优势

LinkedIn 是一个强大的网络平台,为求职者和企业提供联系的机会。 然而,从 LinkedIn 手动提取数据可能是一项费力且耗时的任务。 这就是红宝石刮刀的价值所在。

LinkedIn 数据提取自动化

LinkedIn ruby 网络抓取工具可自动执行从 LinkedIn 个人资料收集数据的过程,无需手动复制和粘贴数据。 使用 ruby LinkedIn scraper,您可以同时从大量个人资料中高效地提取数据。 然后可以将这些数据组织成结构化格式或以多种形式导出,从而节省您的时间来专注于其他重要任务。

有针对性的搜索

LinkedIn 网络抓取与 ruby 允许您根据特定条件进行精确搜索。 例如,您可以搜索特定行业、地点或工作职能的专业人士。 这种有针对性的方法可以帮助您找到合适的人在 LinkedIn 上联系并扩展您的网络。

领英数据分析

ruby 网络抓取工具从 LinkedIn 个人资料中提取大量各种信息,包括职位、公司隶属关系和教育背景。 可以分析这些数据,以深入了解 LinkedIn 上的目标受众。 例如,您可以确定目标受众所从事的行业、他们的职位以及他们工作的公司。 此类数据使您能够重新设计营销信息和外展工作。

构建强大的数据库

通过使用 ruby 的 LinkedIn 网络抓取收集的数据可用于构建目标电子邮件或 LinkedIn 外展活动的综合潜在客户数据库。 使用正确的抓取工具,您可以快速有效地收集大量数据,与手动收集相比,显着减少所需的时间。

促进潜在客户开发

Ruby 网络抓取有助于增强潜在客户开发能力。 通过从 LinkedIn 个人资料中提取数据,您可以识别潜在客户并通过定制的营销信息与他们联系。 反过来,这有助于在 LinkedIn 上产生更多潜在客户并促进您的业务增长。

建立自动化外展流程

ruby LinkedIn scraper 可以与其他工具无缝集成,以开发自动化的外展流程。 例如,您可以使用 ruby scraper 从 LinkedIn 个人资料中提取数据,并将这些数据导入到电子邮件营销或 CRM 工具中。 这种简化的方法可以为您的 LinkedIn 连接提供自动化、有针对性的电子邮件活动,从而节省时间并帮助您维护网络连接。

加强电子邮件营销

对于想要完善电子邮件营销策略的企业来说,LinkedIn ruby 网络抓取工具被证明是非常有价值的。 从 LinkedIn 个人资料和 Sales Navigator 中抓取的数据可用于细分电子邮件列表并创建特定的营销活动。 通过这些抓取的数据,您可以发送个性化且相关的电子邮件,从而提高打开率和点击率。 此外,LinkedIn 数据抓取有助于通过最新、相关且高质量的潜在客户来扩展您的电子邮件列表。

竞争研究

LinkedIn ruby 网络抓取是监控竞争对手的有效工具。 通过从竞争对手的个人资料或 LinkedIn 页面中抓取数据,您可以深入了解其目标受众、内容参与度,甚至识别竞争组织内的关键人员。 这些信息可以为您的 LinkedIn 营销策略提供信息,让您在竞争中处于领先地位。 此外,使用 LinkedIn 帖子抓取工具可以让您分析竞争对手共享的内容及其参与度,从而帮助提高内容的质量和相关性。

如何使用 Ruby LinkedIn Scraper 安全地提取数据?

使用 Ruby 进行 LinkedIn 网络抓取可以为企业和研究人员提供有价值的数据。 然而,以符合道德的方式执行此流程并遵守 LinkedIn 的服务条款非常重要。 为确保您不会遇到任何问题或被平台禁止,请考虑以下最佳实践:

- 控制请求频率: 为了避免 LinkedIn 服务器超载,请限制数据请求的频率并在每个请求之间设置适当的时间间隔。 这有助于保持合理的节奏。

- 模仿人类行为: 抓取数据时,通过使用用户常用的网络浏览器来模仿人类行为。 以自然、现实的速度提出请求,以避免引起怀疑。

- 尊重隐私: 请勿尝试访问私人配置文件或任何未公开的数据。 这可确保您尊重 LinkedIn 用户的隐私。

- 道德使用: 承诺将抓取的数据用于道德目的,并避免任何不道德或有害的做法。 维护 LinkedIn 用户的隐私和诚信。

通过遵守这些道德准则,网络开发人员可以以负责任和道德的方式成功地从 LinkedIn 提取数据,而不会遇到问题或违反平台规则。

底线!

总之,使用 Ruby 进行 LinkedIn 网络抓取为专业人士和企业带来了数以百万计的可能性和机会。 我们希望通过这份综合指南,您能够在遵守道德实践和 LinkedIn 政策的同时提取数据。

Ruby 作为编程语言的多功能性与其超酷的抓取功能相结合,可帮助您访问有价值的数据、构建有针对性的数据库并增强您的营销和推广工作。 借助正确的工具和技术,您可以简化潜在客户开发、完善电子邮件营销活动,甚至通过数据驱动的决策获得竞争优势。

借助 Ruby 网络抓取工具,您可以探索个人和职业发展的潜力,并保持在数据提取技术的最前沿。 在这里获得的技能可以帮助您寻找工作机会、扩展您的网络、推动业务增长等等!

尝试使用 Ruby scraper 从 LinkedIn 提取数据、建立联系并获取无限数据来推动您的业务!